Хронология машинного обучения - Timeline of machine learning

Эта страница график машинное обучение. Включены основные открытия, достижения, вехи и другие важные события.

Обзор

| Десятилетие | Резюме |

|---|---|

| <1950-е годы | Обнаружены и уточнены статистические методы. |

| 1950-е годы | Новаторский машинное обучение исследование проводится с использованием простых алгоритмов. |

| 1960-е | Байесовские методы вводятся для вероятностный вывод в машинном обучении.[1] |

| 1970-е годы | 'AI зима 'вызвано пессимизмом в отношении эффективности машинного обучения. |

| 1980-е | Повторное открытие обратное распространение вызывает возрождение исследований в области машинного обучения. |

| 1990-е | Работа над машинным обучением переходит от подхода, основанного на знаниях, к подходу, основанному на данных. Ученые начинают создавать программы для компьютеров, чтобы анализировать большие объемы данных и делать выводы - или «учиться» - на их результатах.[2] Опорные векторные машины (SVM) и [3]повторяющиеся нейронные сети (RNN) становятся популярными. Поля [4] сложность вычислений с помощью нейронных сетей и вычислений супер-Тьюринга. |

| 2000-е | Кластеризация опорных векторов [5] и другие Методы ядра [6] и методы неконтролируемого машинного обучения получают широкое распространение.[7] |

| 2010-е | Глубокое обучение становится возможным, что приводит к тому, что машинное обучение становится неотъемлемой частью многих широко используемых программных сервисов и приложений. |

Лента новостей

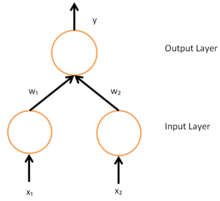

Простая нейронная сеть с двумя модулями ввода и одним модулем вывода

| Год | Тип события | Заголовок | Мероприятие |

|---|---|---|---|

| 1763 | Открытие | Основы Теорема Байеса | Томас Байес работа Эссе к решению проблемы в Доктрине Шанса публикуется через два года после его смерти с поправками и редакцией друга Байеса. Ричард Прайс.[8] В эссе представлены работы, лежащие в основе Теорема Байеса. |

| 1805 | Открытие | Наименьших квадратов | Адриан-Мари Лежандр описывает "méthode des moindres carrés", известный на английском языке как наименьших квадратов метод.[9] Метод наименьших квадратов широко используется в подбор данных. |

| 1812 | Теорема Байеса | Пьер-Симон Лаплас издает Аналитическая теория вероятностей, в которой он расширяет работу Байеса и определяет то, что теперь известно как Теорема Байеса.[10] | |

| 1913 | Открытие | Цепи Маркова | Андрей Марков сначала описывает методы, которые он использовал для анализа стихотворения. Позже эти методы стали известны как Цепи Маркова.[11] |

| 1950 | Обучающая машина Тьюринга | Алан Тьюринг предлагает «обучающуюся машину», которая могла бы обучаться и становиться искусственно разумными. Конкретное предложение Тьюринга предвещает генетические алгоритмы.[12] | |

| 1951 | Первая нейронная сетевая машина | Марвин Мински и Дин Эдмондс создали первую нейронную сетевую машину, способную обучаться, SNARC.[13] | |

| 1952 | Машины, играющие в шашки | Артур Сэмюэл присоединяется к лаборатории IBM Poughkeepsie Laboratory и начинает работать над некоторыми из самых первых программ машинного обучения, создавая сначала программы, которые воспроизводят шашки.[14] | |

| 1957 | Открытие | Перцептрон | Фрэнк Розенблатт изобретает перцептрон во время работы в Корнельская авиационная лаборатория.[15] Изобретение перцептрона вызвало большой ажиотаж и широко освещалось в СМИ.[16] |

| 1963 | Достижение | Машины, играющие в крестики-нолики | Дональд Мичи создает «машину», состоящую из 304 спичечных коробок и бусинок, в которой используется обучение с подкреплением играть Крестики-нолики (также известные как крестики-нолики).[17] |

| 1967 | Ближайший сосед | В алгоритм ближайшего соседа был создан, что является началом базового распознавания образов. Алгоритм использовался для составления карты маршрутов.[2] | |

| 1969 | Ограничения нейронных сетей | Марвин Мински и Сеймур Паперт опубликовать свою книгу Персептроны, описывающих некоторые ограничения перцептронов и нейронных сетей. Интерпретация, которую книга показывает, что нейронные сети фундаментально ограничены, рассматривается как препятствие для исследований нейронных сетей.[18][19] | |

| 1970 | Автоматическое дифференцирование (обратное распространение) | Сеппо Линнаинмаа публикует общий метод автоматического дифференцирования (AD) дискретных связанных сетей вложенных дифференцируемых функций.[20][21] Это соответствует современной версии обратного распространения ошибки, но еще не названо так.[22][23][24][25] | |

| 1979 | Стэнфордская тележка | Студенты Стэнфордского университета разрабатывают тележку, которая может перемещаться по комнате и избегать препятствий.[2] | |

| 1979 | Открытие | Неокогнитрон | Кунихико Фукусима впервые публикует свои работы по неокогнитрон, тип искусственная нейронная сеть (АННА).[26][27] Неопознание позже вдохновляет сверточные нейронные сети (CNN).[28] |

| 1981 | Обучение на основе объяснений | Джеральд Деджонг вводит обучение на основе объяснений, когда компьютерный алгоритм анализирует данные и создает общее правило, которому он может следовать, и отбрасывать неважные данные.[2] | |

| 1982 | Открытие | Рекуррентная нейронная сеть | Джон Хопфилд популяризирует Сети Хопфилда, тип рекуррентная нейронная сеть что может служить память с адресацией по содержимому системы.[29] |

| 1985 | NetTalk | Терри Сейновски разработал программу, которая учится произносить слова так же, как и ребенок.[2] | |

| 1986 | заявка | Обратное распространение | Сеппо Линнаинмаа обратный режим автоматическая дифференциация (впервые применено к нейронным сетям Пол Вербос ) используется в экспериментах Дэвид Румелхарт, Джефф Хинтон и Рональд Дж. Уильямс учиться внутренние представления.[30] |

| 1989 | Открытие | Обучение с подкреплением | Кристофер Уоткинс развивает Q-обучение, что значительно повышает практичность и выполнимость обучение с подкреплением.[31] |

| 1989 | Коммерциализация | Коммерциализация машинного обучения на персональных компьютерах | Выпуски Axcelis, Inc. Evolver, первый программный пакет, коммерциализирующий использование генетических алгоритмов на персональных компьютерах.[32] |

| 1992 | Достижение | Машины, играющие в нарды | Джеральд Тезауро развивает TD-Gammon, компьютер нарды программа, использующая искусственная нейронная сеть обучен с использованием обучение с разницей во времени (отсюда и "TD" в названии). TD-Gammon может соперничать с лучшими игроками в нарды, но не всегда превосходить их.[33] |

| 1995 | Открытие | Алгоритм случайного леса | Тин Кам Хо публикует статью с описанием леса случайных решений.[34] |

| 1995 | Открытие | Машины опорных векторов | Коринна Кортес и Владимир Вапник публиковать свои работы на опорные векторные машины.[35][36] |

| 1997 | Достижение | IBM Deep Blue превосходит Каспарова | IBM Темно-синий обыгрывает чемпиона мира по шахматам.[2] |

| 1997 | Открытие | LSTM | Зепп Хохрайтер и Юрген Шмидхубер изобретать долговременная кратковременная память (LSTM) рекуррентные нейронные сети,[37] значительно повышая эффективность и практичность рекуррентных нейронных сетей. |

| 1998 | База данных MNIST | Команда во главе с Янн ЛеКун выпускает База данных MNIST, набор данных, состоящий из рукописных цифр из Американское бюро переписи населения сотрудников и американских школьников.[38] База данных MNIST с тех пор стала эталоном для оценки распознавания рукописного ввода. | |

| 2002 | Библиотека машинного обучения Torch | Факел впервые выпущена программная библиотека для машинного обучения.[39] | |

| 2006 | Приз Netflix | В Приз Netflix конкурс запускается Netflix. Цель конкурса заключалась в том, чтобы использовать машинное обучение, чтобы превзойти точность собственного рекомендательного программного обеспечения Netflix при прогнозировании рейтинга пользователя для фильма с учетом их оценок за предыдущие фильмы не менее чем на 10%.[40] Приз был выигран в 2009 году. | |

| 2009 | Достижение | ImageNet | ImageNet создано. ImageNet - это большая визуальная база данных, созданная Фэй-Фэй Ли из Стэнфордского университета, который понял, что лучшие алгоритмы машинного обучения не будут работать, если данные не будут отражать реальный мир.[41] Для многих ImageNet стал катализатором бума искусственного интеллекта[42] 21 века. |

| 2010 | Конкурс Kaggle | Kaggle, веб-сайт, служащий платформой для соревнований по машинному обучению.[43] | |

| 2010 | Wall Street Journal сообщает об инвестициях в машинное обучение | WSJ Profiles представляет собой новую волну инвестиций и фокусируется на RebellionResearch.com, который станет предметом романа автора Скотта Паттерсона «Темные бассейны».[44] | |

| 2011 | Достижение | Победа над людьми в опасности | Используя комбинацию машинного обучения, обработка естественного языка и методы поиска информации, IBM с Watson побеждает двух чемпионов-людей в Опасность! соревнование.[45] |

| 2012 | Достижение | Как узнать кошек на YouTube | В Google Brain команда, возглавляемая Эндрю Нг и Джефф Дин, создайте нейронную сеть, которая учится распознавать кошек, просматривая немаркированные изображения, взятые из кадров YouTube ролики.[46][47] |

| 2014 | Скачок в распознавании лиц | Facebook исследователи публикуют свои работы на DeepFace, система, использующая нейронные сети, которые идентифицируют лица с точностью 97,35%. Результат - улучшение более чем на 27% по сравнению с предыдущими системами и конкуренция с производительностью человека.[48] | |

| 2014 | Сивилла | Исследователи из Google подробно описывают свою работу о Сивилле,[49] запатентованная платформа для массового параллельного машинного обучения, используемая Google внутри компании для прогнозирования поведения пользователей и предоставления рекомендаций.[50] | |

| 2016 | Достижение | Победа над людьми на ходу | Google AlphaGo программа становится первой Computer Go программа, чтобы обыграть профессионального игрока с ограниченными возможностями[51] используя сочетание машинного обучения и методов поиска по дереву.[52] Позже улучшился как AlphaGo Zero а затем в 2017 году обобщены на шахматы и другие игры для двух игроков с AlphaZero. |

Смотрите также

- История искусственного интеллекта

- Машинное обучение

- Хронология искусственного интеллекта

- Хронология машинного перевода

использованная литература

- ^ Соломонов, Рэй Дж. "Формальная теория индуктивного вывода. Часть II". Информация и управление 7.2 (1964): 224–254.

- ^ а б c d е ж Марр, Бернард. «Краткая история машинного обучения - должен прочитать каждый менеджер». Forbes. Получено 28 сен 2016.

- ^ Зигельманн, Хава; Зонтаг, Эдуардо (1995). «Вычислительная мощность нейронных сетей». Журнал компьютерных и системных наук. 50 (1): 132–150. Дои:10.1006 / jcss.1995.1013.

- ^ Зигельманн, Хава (1995). «Вычисления за пределом Тьюринга». Журнал компьютерных и системных наук. 238 (28): 632–637. Bibcode:1995Sci ... 268..545S. Дои:10.1126 / science.268.5210.545. PMID 17756722.

- ^ Бен-Гур, Аса; Хорн, Дэвид; Зигельманн, Хава; Вапник, Владимир (2001). «Поддержка векторной кластеризации». Журнал исследований в области машинного обучения. 2: 51–86.

- ^ Хофманн, Томас; Шёлкопф, Бернхард; Смола, Александр Дж. (2008). «Ядровые методы в машинном обучении». Анналы статистики. 36 (3): 1171–1220. Дои:10.1214/009053607000000677. JSTOR 25464664.

- ^ Беннетт, Джеймс; Лэннинг, Стэн (2007). "Приз netflix" (PDF). Материалы Кубка и Мастерской KDD 2007.

- ^ Байес, Томас (1 января 1763 г.). «Эссе к решению проблемы в Доктрине случая». Философские труды. 53: 370–418. Дои:10.1098 / рстл.1763.0053. JSTOR 105741.

- ^ Лежандр, Адриан-Мари (1805). Новые методы определения орбиты комет (На французском). Париж: Фирмин Дидо. п. viii. Получено 13 июн 2016.

- ^ О'Коннор, Дж. Дж .; Робертсон, Э. Ф. "Пьер-Симон Лаплас". Школа математики и статистики Университета Сент-Эндрюс, Шотландия. Получено 15 июн 2016.

- ^ Хейс, Брайан (2013). «Первые звенья цепи Маркова». Американский ученый. Сигма Си, Общество научных исследований. 101 (Март – апрель 2013 г.): 92. Дои:10.1511/2013.101.1. Получено 15 июн 2016.

Углубляясь в текст романа Александра Пушкина в стихах «Евгений Онегин», Марков часами просеивал образцы гласных и согласных. 23 января 1913 года он резюмировал свои выводы в обращении к Императорской Академии наук в Санкт-Петербурге. Его анализ не изменил понимания или оценки стихотворения Пушкина, но разработанная им техника - теперь известная как цепь Маркова - расширила теорию вероятностей в новом направлении.

- ^ Тьюринг, Алан (октябрь 1950 г.). «Вычислительная техника и интеллект». Разум. 59 (236): 433–460. Дои:10.1093 / разум / LIX.236.433. Получено 8 июн 2016.

- ^ Crevier 1993, стр. 34–35 и Рассел и Норвиг, 2003 г., п. 17

- ^ Маккарти, Джон; Фейгенбаум / Под ред. «Артур Сэмюэл: пионер машинного обучения». Журнал AI (3). Ассоциация развития искусственного интеллекта. п. 10. Получено 5 июн 2016.

- ^ Розенблатт, Франк (1958). «Персептрон: вероятностная модель хранения и организации информации в мозгу» (PDF). Психологический обзор. 65 (6): 386–408. Дои:10,1037 / ч0042519. PMID 13602029.

- ^ Мейсон, Хардинг; Стюарт, Д.; Гилл, Брендан (6 декабря 1958 г.). "Соперник". Житель Нью-Йорка. Получено 5 июн 2016.

- ^ Чайлд, Оливер (13 марта 2016 г.). "Угроза: Машинное обучение". Журнал Chalkdust. Получено 16 января 2018.

- ^ Коэн, Харви. "Персептрон". Получено 5 июн 2016.

- ^ Колнер, Роберт (4 марта 2016 г.). «Краткая история машинного обучения». SlideShare. Получено 5 июн 2016.

- ^ Сеппо Линнаинмаа (1970). «Представление совокупной ошибки округления алгоритма в виде разложения Тейлора локальных ошибок округления». Магистерская работа (на финском языке), Univ. Хельсинки, 6–7.

- ^ Линнаинмаа, Сеппо (1976). «Разложение Тейлора накопленной ошибки округления». BIT вычислительная математика. 16 (2): 146–160. Дои:10.1007 / BF01931367.

- ^ Гриванк, Андреас (2012). «Кто изобрел обратный способ дифференциации?». Documenta Matematica, дополнительный том ISMP: 389–400.

- ^ Гриванк, Андреас и Вальтер, А. Принципы и методы алгоритмической дифференциации, второе издание. СИАМ, 2008.

- ^ Шмидхубер, Юрген (2015). «Глубокое обучение в нейронных сетях: обзор». Нейронные сети. 61: 85–117. arXiv:1404.7828. Bibcode:2014arXiv1404.7828S. Дои:10.1016 / j.neunet.2014.09.003. PMID 25462637.

- ^ Шмидхубер, Юрген (2015). «Глубокое обучение (раздел по обратному распространению)». Scholarpedia. 10 (11): 32832. Bibcode:2015SchpJ..1032832S. Дои:10.4249 / scholarpedia.32832.

- ^ Фукусима, Кунихико (октябрь 1979 г.). «位置 ず れ に 影響 さ い パ 認識 機構 の 神 経 回路 の ル --- ネ オ コ グ ト ---» [Модель нейронной сети для механизма распознавания образов, не подверженного изменению положения - Neocognitron -]. Пер. IECE (по-японски). J62-A (10): 658–665.

- ^ Фукусима, Кунихико (апрель 1980 г.). "Неокогнитрон: модель самоорганизующейся нейронной сети для механизма паттерна" Рекогнитрон, не подверженный изменению положения " (PDF). Биологическая кибернетика. 36 (4): 193–202. Дои:10.1007 / bf00344251. PMID 7370364. Получено 5 июн 2016.

- ^ Ле Кун, Янн. «Глубокое обучение». CiteSeerX 10.1.1.297.6176. Цитировать журнал требует

| журнал =(Помогите) - ^ Хопфилд, Джон (апрель 1982). «Нейронные сети и физические системы с возникающими коллективными вычислительными возможностями» (PDF). Труды Национальной академии наук Соединенных Штатов Америки. 79 (8): 2554–2558. Bibcode:1982PNAS ... 79.2554H. Дои:10.1073 / pnas.79.8.2554. ЧВК 346238. PMID 6953413. Получено 8 июн 2016.

- ^ Румелхарт, Дэвид; Хинтон, Джеффри; Уильямс, Рональд (9 октября 1986 г.). «Изучение представлений путем обратного распространения ошибок» (PDF). Природа. 323 (6088): 533–536. Bibcode:1986Натура.323..533R. Дои:10.1038 / 323533a0. Получено 5 июн 2016.

- ^ Уотксин, Кристофер (1 мая 1989 г.). «Учимся на отсроченных вознаграждениях» (PDF). Цитировать журнал требует

| журнал =(Помогите) - ^ Марков, Джон (29 августа 1990). «БИЗНЕС-ТЕХНОЛОГИИ; какой лучший ответ? Это выживание сильнейших». Газета "Нью-Йорк Таймс. Получено 8 июн 2016.

- ^ Тесауро, Джеральд (март 1995). "Изучение временной разницы и TD-Gammon". Коммуникации ACM. 38 (3): 58–68. Дои:10.1145/203330.203343.

- ^ Хо, Тин Кам (август 1995 г.). «Леса случайного решения» (PDF). Труды Третьей Международной конференции по анализу и распознаванию документов. Монреаль, Квебек: IEEE. 1: 278–282. Дои:10.1109 / ICDAR.1995.598994. ISBN 0-8186-7128-9. Получено 5 июн 2016.

- ^ Голге, Эрен. «КРАТКАЯ ИСТОРИЯ МАШИННОГО ОБУЧЕНИЯ». Блог человека-инженера. Получено 5 июн 2016.

- ^ Кортес, Коринна; Вапник, Владимир (сентябрь 1995 г.). «Поддержка-вектор сети». Машинное обучение. Kluwer Academic Publishers. 20 (3): 273–297. Дои:10.1007 / BF00994018. ISSN 0885-6125.

- ^ Хохрайтер, Зепп; Шмидхубер, Юрген (1997). «Кратковременная долговременная память» (PDF). Нейронные вычисления. 9 (8): 1735–1780. Дои:10.1162 / neco.1997.9.8.1735. PMID 9377276. Архивировано из оригинал (PDF) на 2015-05-26.

- ^ ЛеКун, Янн; Кортес, Коринна; Берджес, Кристофер. "БАЗА ДАННЫХ рукописных цифр MNIST". Получено 16 июн 2016.

- ^ Коллобер, Ронан; Бениго, Сами; Мариетоз, Джонни (30 октября 2002 г.). «Torch: модульная библиотека программного обеспечения для машинного обучения» (PDF). Получено 5 июн 2016. Цитировать журнал требует

| журнал =(Помогите) - ^ «Правила приза Netflix». Приз Netflix. Netflix. Архивировано из оригинал 3 марта 2012 г.. Получено 16 июн 2016.

- ^ Гершгорн, Дэйв. «ImageNet: данные, породившие нынешний бум искусственного интеллекта - Quartz». qz.com. Получено 2018-03-30.

- ^ Харди, Квентин (18.07.2016). «Причины верить в реальность бума ИИ». Нью-Йорк Таймс. ISSN 0362-4331. Получено 2018-03-30.

- ^ "Около". Kaggle. Kaggle Inc. Получено 16 июн 2016.

- ^ "Около".

- ^ Марков, Джон (17 февраля 2011 г.). «Компьютер побеждает в 'Jeopardy!': Тривиально, это не так». Газета "Нью-Йорк Таймс. п. A1. Получено 5 июн 2016.

- ^ Le, Quoc V .; Ранзато, Марк'Аурелио; Монга, Раджат; Девин, Матье; Коррадо, Грег; Чен, Кай; Дин, Джеффри; Нг, Эндрю Ю. (2012). «Создание высокоуровневых функций с использованием крупномасштабного обучения без учителя» (PDF). Материалы 29-й Международной конференции по машинному обучению, ICML 2012, Эдинбург, Шотландия, Великобритания, 26 июня - 1 июля 2012 г.. icml.cc / Omnipress. arXiv:1112.6209. Bibcode:2011arXiv1112.6209L.

- ^ Марков, Джон (26 июня 2012 г.). «Сколько компьютеров для идентификации кошки? 16 000». Газета "Нью-Йорк Таймс. п. B1. Получено 5 июн 2016.

- ^ Тайгман, Янив; Ян, Мин; Ранзато, Марк'Аурелио; Вольф, Лиор (24 июня 2014 г.). «DeepFace: устранение пробелов в человеческом уровне при проверке лица». Конференция по компьютерному зрению и распознаванию образов. Получено 8 июн 2016.

- ^ Канини, Кевин; Чандра, Тушар; Т.е., Евгений; Макфадден, Джим; Гольдман, Кен; Гюнтер, Майк; Хармсен, Иеремия; ЛеФевр, Кристен; Лепихин, Дмитрий; Ллинарес, Томас Льорет; Мукерджи, Индранил; Перейра, Фернандо; Редстоун, Джош; Шакед, Таль; Певец, Йорам. «Сибилла: система для крупномасштабного машинного обучения с учителем» (PDF). Школа инженеров Джека Баскина. Калифорнийский университет в Санта-Крус. Получено 8 июн 2016.

- ^ Вуди, Алекс (17 июля 2014 г.). "Inside Sibyl, платформа параллельного машинного обучения Google". Датанами. Tabor Communications. Получено 8 июн 2016.

- ^ «Google совершил« прорыв »в области ИИ, победив чемпиона по го». Новости BBC. BBC. 27 января 2016 г.. Получено 5 июн 2016.

- ^ "AlphaGo". Google DeepMind. Google Inc. Получено 5 июн 2016.