Общий искусственный интеллект - Artificial general intelligence

| Часть серии по |

| Искусственный интеллект |

|---|

Технологии |

Глоссарий |

Общий искусственный интеллект (AGI) является гипотетическим[1] интеллект машины, способной понять или изучить любую интеллектуальную задачу, которую человек может. Это основная цель некоторых искусственный интеллект исследования и общая тема в научная фантастика и фьючерсные исследования. AGI также можно назвать сильный ИИ,[2][3][4] полный ИИ,[5] или же общее разумное действие.[6] Некоторые академические источники резервируют термин «сильный ИИ» для машин, которые могут сознание.[7] Предполагается, что сегодняшний ИИ находится на расстоянии десятилетий от AGI.[8][9]

В отличие от сильного ИИ, слабый ИИ[10] (также называемый узким ИИ[3]) не предназначен для выполнения человеком познавательный Возможности, скорее, слабый ИИ ограничивается использованием программного обеспечения для изучения или выполнения конкретных решение проблем или же рассуждение задачи.

По состоянию на 2017 год более 40 организаций активно исследуют AGI.[11]

Требования

Различные критерии для интеллект были предложены (наиболее известный Тест Тьюринга ), но на сегодняшний день нет определения, которое бы всех устраивало.[12] Однако там является Среди исследователей искусственного интеллекта широко распространено мнение о том, что интеллект необходим для выполнения следующих задач:[13]

- причина, используйте стратегию, решайте головоломки и судите неуверенность;

- представлять знания, включая здравый смысл;

- строить планы;

- учиться;

- общаться в естественный язык;

- и интегрировать все эти навыки к общим целям.

Другие важные возможности включают способность смысл (например. видеть ) и способность действовать (например, перемещать и манипулировать объектами ) в мире, где следует наблюдать разумное поведение.[14] Это будет включать способность обнаруживать и реагировать на опасность.[15] Многие междисциплинарные подходы к интеллекту (например, наука о мышлении, вычислительный интеллект и принимать решение ), как правило, подчеркивают необходимость учета дополнительных черт, таких как воображение (воспринимается как способность формировать мысленные образы и концепции, которые не были запрограммированы)[16] и автономия.[17]Компьютерные системы, которые демонстрируют многие из этих возможностей, действительно существуют (например, см. вычислительное творчество, автоматическое рассуждение, система поддержки принятия решений, робот, эволюционные вычисления, интеллектуальный агент ), но еще не на человеческом уровне.

Тесты для подтверждения ОИИ человеческого уровня

Были рассмотрены следующие тесты для подтверждения AGI человеческого уровня:[18][19]

- Тест Тьюринга (Тьюринг )

- И машина, и человек незримо общаются со вторым человеком, который должен оценить, какая из двух является машиной, и которая выдержит испытание, если сможет обмануть оценщика значительную часть времени. Примечание: Тьюринг не предписывает, что следует квалифицировать как интеллект, только то, что знание того, что это машина, должно его дисквалифицировать.

- Кофе-тест (Возняк )

- Чтобы войти в средний американский дом и выяснить, как приготовить кофе, требуется машина: найти кофемашину, найти кофе, долить воды, найти кружку и сварить кофе, нажав соответствующие кнопки.

- Тест студента колледжа роботов (Goertzel )

- Машина поступает в университет, берет и проходит те же курсы, что и люди, и получает ученую степень.

- Тест на трудоустройство (Нильссон )

- Машина выполняет экономически важную работу, выполняя ту же работу не хуже, чем человек.

Проблемы, требующие решения от AGI

Наиболее сложные проблемы для компьютеров неофициально известны как «AI-complete» или «AI-hard», подразумевая, что их решение эквивалентно общим способностям человеческого интеллекта или сильному AI, за пределами возможностей целевого алгоритма.[20]

Предполагается, что проблемы с ИИ включают в себя общие компьютерное зрение, понимание естественного языка, и работа с неожиданными обстоятельствами при решении любой реальной проблемы.[21]

Проблемы с ИИ не могут быть решены с помощью одних только современных компьютерных технологий, а также требуют человеческое вычисление. Это свойство может быть полезно, например, для проверки присутствия людей, так как CAPTCHA стремиться делать; и для компьютерная безопасность оттолкнуть атаки методом перебора.[22][23]

История

Классический ИИ

Современные исследования ИИ начались в середине 1950-х годов.[24] Первое поколение исследователей ИИ было убеждено, что общий искусственный интеллект возможен и что он будет существовать всего через несколько десятилетий. Пионер ИИ Герберт А. Саймон писал в 1965 году: «В течение двадцати лет машины будут способны выполнять любую работу, которую может выполнять человек».[25] Их прогнозы послужили источником вдохновения для Стэнли Кубрик и Артур Кларк характер HAL 9000, которые воплотили то, что, по мнению исследователей ИИ, они могут создать к 2001 году. Пионер ИИ Марвин Мински был консультантом[26] о проекте сделать HAL 9000 как можно более реалистичным в соответствии с общепринятыми прогнозами того времени; Кревье цитирует его слова по этому поводу в 1967 году: «В течение одного поколения ... проблема создания« искусственного интеллекта »будет существенно решена».[27] хотя Мински заявляет, что он был неправильно процитирован.[нужна цитата ]

Однако в начале 1970-х стало очевидно, что исследователи сильно недооценили сложность проекта. Финансовые агентства стали скептически относиться к AGI и оказали на исследователей все большее давление с целью создания полезного «прикладного ИИ».[28] В начале 1980-х годов Япония Компьютер пятого поколения Проект возродил интерес к AGI, установив десятилетний график, который включал такие цели AGI, как «вести непринужденный разговор».[29] В ответ на это и успех экспертные системы, и промышленность, и правительство закачивали деньги обратно в эту отрасль.[30] Однако в конце 80-х годов прошлого века доверие к ИИ резко упало, и цели компьютерного проекта пятого поколения так и не были достигнуты.[31] Второй раз за 20 лет выяснилось, что исследователи искусственного интеллекта, предсказавшие неминуемое достижение AGI, в корне ошибались. К 1990-м годам исследователи ИИ приобрели репутацию тех, кто дает пустые обещания. Они вообще перестали делать прогнозы[32] и избегать любого упоминания об искусственном интеллекте «человеческого уровня» из-за боязни быть названным «мечтателем с безумными глазами».[33]

Узкие исследования ИИ

В 1990-х и начале 21-го века основной ИИ достиг гораздо большего коммерческого успеха и академической респектабельности, сосредоточившись на конкретных подзадачах, где они могут давать проверяемые результаты и коммерческие приложения, такие как искусственные нейронные сети и статистические машинное обучение.[34] Эти «прикладные системы искусственного интеллекта» теперь широко используются во всей технологической отрасли, и исследования в этом направлении очень сильно финансируются как в академических кругах, так и в промышленности. В настоящее время разработка этого месторождения считается развивающейся тенденцией, и ожидается, что она станет зрелой через более чем 10 лет.[35]

Большинство основных исследователей ИИ надеются, что сильный ИИ можно разработать, объединив программы, решающие различные подзадачи. Ганс Моравец писал в 1988 году:

"Я уверен, что этот восходящий путь к искусственному интеллекту однажды встретит более чем половину пути традиционного нисходящего пути, готовый предоставить реальную компетенцию и здравый смысл это было так удручающе неуловимо в программах рассуждений. Полностью интеллектуальные машины появятся, когда метафорическое золотой шип движется объединением двух усилий ".[36]

Однако даже эта фундаментальная философия оспаривается; например, Стеван Харнад из Принстона завершил свою статью 1990 г. Гипотеза о заземлении символа заявив:

«Часто высказывалось ожидание, что« нисходящие »(символические) подходы к моделированию познания каким-то образом будут встречаться с« восходящими »(сенсорными) подходами где-то посередине. Если обосновывающие соображения в этой статье верны, то это ожидание справедливо. безнадежно модульный, и на самом деле существует только один жизнеспособный путь от смысла к символам: с нуля. Свободно плавающий символический уровень, такой как уровень программного обеспечения компьютера, никогда не будет достигнут этим путем (или наоборот) - и это не ясно почему мы должны даже пытаться достичь такого уровня, поскольку кажется, что достижение этого уровня означало бы просто искоренить наши символы из их внутреннего значения (тем самым просто уменьшив себя до функционального эквивалента программируемого компьютера) ».[37]

Современные исследования общего искусственного интеллекта

Термин «общий искусственный интеллект» использовал еще в 1997 г. Марк Губруд.[38] в обсуждении последствий полностью автоматизированного военного производства и операций. Термин был повторно введен и популяризирован Шейн Легг и Бен Гертцель около 2002 г.[39] Задача исследования намного старше, например Дуг Ленат с Цикл проект (начат в 1984 г.) и Аллен Ньюэлл с Парить рассматриваются как находящиеся в сфере компетенции AGI. Исследовательскую деятельность AGI в 2006 году описали Пей Ван и Бен Герцель.[40] как «подготовка публикаций и предварительных результатов». Первая летняя школа AGI была организована в Сямыне, Китай, в 2009 году.[41] Лабораторией искусственного мозга Сямэньского университета и OpenCog. Первый университетский курс был открыт в 2010 году.[42] и 2011[43] в Пловдивском университете, Болгария, Тодор Арнаудов. В 2018 году Массачусетский технологический институт представил курс по AGI, организованный Лексом Фридманом и с участием ряда приглашенных лекторов. Однако до сих пор большинство исследователей искусственного интеллекта уделяют мало внимания ОИИ, а некоторые утверждают, что интеллект слишком сложен, чтобы его можно было полностью воспроизвести в ближайшем будущем. Однако небольшое количество компьютерных ученых активно участвует в исследованиях AGI, и многие из этой группы вносят свой вклад в серию AGI конференции. Исследования чрезвычайно разнообразны и часто носят новаторский характер. Во введении к своей книге[44] Гертцель говорит, что оценки времени, необходимого для создания действительно гибкого AGI, варьируются от 10 лет до более чем столетия, но в исследовательском сообществе AGI, похоже, консенсус в том, что сроки, обсуждаемые Рэй Курцвейл в Сингулярность близка[45] (т.е. между 2015 и 2045 годами) вполне правдоподобно.[46]

Однако основные исследователи искусственного интеллекта высказали широкий спектр мнений о том, будет ли прогресс столь быстрым. Мета-анализ 95 таких мнений, проведенный в 2012 году, выявил предвзятость в отношении предсказания того, что начало AGI произойдет в течение 16–26 лет как для современных, так и для исторических прогнозов. Позже выяснилось, что в наборе данных некоторые эксперты были указаны как неспециалисты, и наоборот.[47]

Организации, явно стремящиеся к AGI, включают швейцарскую лабораторию искусственного интеллекта. IDSIA,[48] Ннайзенс,[49] Заместитель, Малууба,[11] то Фонд OpenCog, Адаптивный ИИ, LIDA, и Numenta и связанные Институт неврологии Редвуд.[50] Кроме того, такие организации, как Научно-исследовательский институт машинного интеллекта[51] и OpenAI[52] были созданы, чтобы повлиять на путь развития AGI. Наконец, такие проекты, как Проект человеческого мозга[53] имеют цель построить симуляцию функционирования человеческого мозга. В опросе AGI, проведенном в 2017 году, было классифицировано сорок пять известных «активных научно-исследовательских проектов», которые прямо или косвенно (посредством опубликованных исследований) исследуют AGI, из которых три крупнейших DeepMind, Проект "Человеческий мозг" и OpenAI.[11]

В 2017 г.[нужна цитата ] Бен Гертцель основал AI-платформу SingularityNET с целью облегчения демократического, децентрализованного контроля над AGI, когда он появится.[54]

В 2017 году исследователи Фэн Лю, Юн Ши и Ин Лю провели тесты интеллекта на общедоступных и свободно доступных слабых ИИ, таких как Google AI, Apple Siri и другие. В максимуме эти ИИ достигли значения IQ около 47, что примерно соответствует шестилетнему ребенку в первом классе. Взрослый человек в среднем составляет около 100 человек. Аналогичные тесты были проведены в 2014 году, при этом максимальное значение IQ достигло 27.[55][56]

В 2019 году программист видеоигр и аэрокосмический инженер. Джон Кармак объявил о планах исследования AGI.[57]

В 2020 г. OpenAI развитый GPT-3, языковая модель, способная выполнять множество разнообразных задач без специального обучения. По словам Гэри Гроссмана в VentureBeat в статье, хотя существует консенсус в отношении того, что GPT-3 не является примером AGI, некоторые считают его слишком продвинутым, чтобы классифицировать его как узкую систему ИИ.[58]

Мощность обработки, необходимая для моделирования мозга

Эмуляция всего мозга

Популярный обсуждаемый подход к достижению общего разумного действия - эмуляция всего мозга. Модель мозга нижнего уровня построена сканирование и отображение детальный биологический мозг и копирование его состояния в компьютерную систему или другое вычислительное устройство. На компьютере работает симуляция Модель настолько верна оригиналу, что будет вести себя практически так же, как и исходный мозг, или для всех практических целей неотличима.[59] Эмуляция всего мозга обсуждается в вычислительная нейробиология и нейроинформатика, в контексте моделирование мозга для медицинских исследовательских целей. Это обсуждается в искусственный интеллект исследование[46] как подход к сильному ИИ. Нейровизуализация технологии, которые могут обеспечить необходимое детальное понимание, быстро улучшаются, и футурист Рэй Курцвейл в книге Сингулярность близка[45] предсказывает, что карта достаточного качества станет доступной в том же масштабе времени, что и требуемые вычислительные мощности.

Ранние оценки

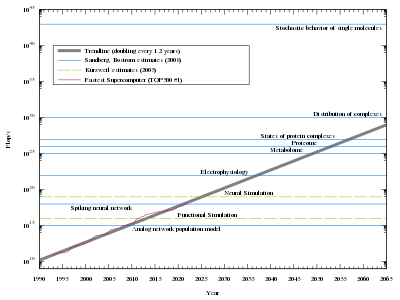

Для низкоуровневого моделирования мозга потребуется чрезвычайно мощный компьютер. В человеческий мозг имеет огромное количество синапсы. Каждый из 1011 (сто миллиардов) нейроны имеет в среднем 7000 синаптических связей (синапсов) с другими нейронами. Было подсчитано, что в мозгу трехлетнего ребенка около 1015 синапсы (1 квадриллион). Это число снижается с возрастом и стабилизируется к зрелому возрасту. Оценки варьируются для взрослого: от 1014 до 5 × 1014 синапсов (от 100 до 500 триллионов).[61] Оценка вычислительной мощности мозга, основанная на простой модели переключения нейронной активности, составляет около 1014 (100 триллионов) синаптических обновлений в секунду (SUPS ).[62] В 1997 году Курцвейл рассмотрел различные оценки оборудования, необходимого для того, чтобы соответствовать человеческому мозгу, и принял число 10.16 вычислений в секунду (cps).[63] (Для сравнения, если «вычисление» было эквивалентно одному «операция с плавающей запятой "- мера, используемая для оценки текущего суперкомпьютеры - тогда 1016 "вычисления" будут эквивалентны 10 петафлопс, достигнуто в 2011 году ). Он использовал эту цифру, чтобы спрогнозировать, что необходимое оборудование будет доступно где-то между 2015 и 2025 годами, если экспоненциальный рост мощности компьютеров на момент написания статьи продолжится.

Более детальное моделирование нейронов

В искусственный нейрон модель, принятая Курцвейлом и используемая во многих современных искусственная нейронная сеть реализация проста по сравнению с биологические нейроны. Имитация мозга, вероятно, должна будет фиксировать детальное клеточное поведение биологических нейроны, в настоящее время понимается только в самом широком смысле. Накладные расходы, связанные с полным моделированием биологических, химических и физических деталей нейронного поведения (особенно в молекулярном масштабе), потребуют вычислительных мощностей на несколько порядков больше, чем оценка Курцвейла. Кроме того, оценки не учитывают глиальные клетки, которые по крайней мере так же многочисленны, как нейроны, и которые могут превосходить число нейронов в 10: 1, и теперь известно, что они играют роль в когнитивных процессах.[64]

Текущее исследование

Есть несколько исследовательских проектов, которые исследуют моделирование мозга с использованием более сложных нейронных моделей, реализованных на традиционных вычислительных архитектурах. В Система искусственного интеллекта в проекте реализовано моделирование «мозга» не в реальном времени (с 1011 нейроны) в 2005 г. Потребовалось 50 дней на кластере из 27 процессоров, чтобы смоделировать 1 секунду модели.[65] В Синий мозг в проекте использовалась одна из самых быстрых суперкомпьютерных архитектур в мире, IBM с Синий ген платформа, чтобы создать симуляцию в реальном времени одной крысы неокортикальный столб состоящий примерно из 10 000 нейронов и 108 синапсов в 2006 году.[66] Долгосрочная цель - построить детальное функциональное моделирование физиологических процессов в человеческом мозге: «Человеческий мозг не невозможно построить, и мы можем это сделать за 10 лет», Генри Маркрам - заявил в 2009 году директор проекта «Голубой мозг» Конференция TED в Оксфорде.[67] Также были спорные утверждения о моделировании кошачий мозг. Нейро-кремниевые интерфейсы были предложены в качестве альтернативной стратегии реализации, которая может лучше масштабироваться.[68]

Ганс Моравец рассмотрел приведенные выше аргументы («мозг сложнее», «нейроны необходимо моделировать более подробно») в своей статье 1997 года «Когда компьютерное оборудование будет соответствовать человеческому мозгу?».[69] Он измерил способность существующего программного обеспечения имитировать функциональность нервной ткани, в частности сетчатки. Его результаты не зависят ни от количества глиальных клеток, ни от того, какие типы обрабатывающих нейронов и где их выполняют.

Фактическая сложность моделирования биологических нейронов исследовалась в Проект OpenWorm Это было направлено на полное моделирование червя, у которого всего 302 нейрона в своей нейронной сети (всего около 1000 клеток). Нейронная сеть животного была хорошо задокументирована до начала проекта. Однако, хотя вначале задача казалась простой, модели, основанные на общей нейронной сети, не работали. В настоящее время усилия сосредоточены на точной имитации биологических нейронов (частично на молекулярном уровне), но результат пока нельзя назвать полным успехом. Даже если количество задач, которые необходимо решить в модели человеческого мозга, не пропорционально количеству нейронов, объем работы на этом пути очевиден.

Критика подходов, основанных на моделировании

Фундаментальная критика подхода к моделированию мозга происходит от воплощенное познание где человеческое воплощение рассматривается как важнейший аспект человеческого разума. Многие исследователи считают, что воплощение необходимо для обоснования смысла.[70] Если эта точка зрения верна, любая полностью функциональная модель мозга должна будет охватывать больше, чем просто нейроны (то есть тело робота). Goertzel[46] предлагает виртуальное воплощение (как в Вторая жизнь ), но пока не известно, будет ли этого достаточно.

Настольные компьютеры с микропроцессорами, способными более 109 cps (нестандартная единица «вычислений в секунду» Курцвейла, см. выше) доступна с 2005 года. Согласно оценкам мощности мозга, используемым Курцвейлом (и Моравеком), этот компьютер должен поддерживать моделирование мозга пчелы, но несмотря на некоторый интерес[71] такой симуляции не существует[нужна цитата ]. На это есть как минимум три причины:

- Модель нейрона кажется слишком упрощенной (см. Следующий раздел).

- Недостаточное понимание высших когнитивных процессов[72] чтобы точно установить, какая нервная активность мозга, наблюдаемая с помощью таких методов, как функциональная магнитно-резонансная томография, коррелирует с.

- Даже если наше понимание познания улучшится, ранние программы моделирования, вероятно, будут очень неэффективными и, следовательно, потребуют значительно большего количества оборудования.

- Мозг организма, хотя и имеет решающее значение, может не быть подходящей границей для когнитивной модели. Чтобы смоделировать мозг пчелы, может потребоваться моделирование тела и окружающей среды. Расширенный разум диссертация формализует философскую концепцию, а исследование головоногие моллюски продемонстрировал наглядные примеры децентрализованной системы.[73]

Кроме того, масштабы человеческого мозга в настоящее время плохо ограничены. По одной оценке, человеческий мозг насчитывает около 100 миллиардов нейронов и 100 триллионов синапсов.[74][75] По другой оценке, 86 миллиардов нейронов, из которых 16,3 миллиарда находятся в кора головного мозга и 69 миллиардов в мозжечок.[76] Глиальная клетка количество синапсов в настоящее время не определено, но известно, что их очень много.

Сильный ИИ и сознание

В 1980 году философ Джон Сирл придумал термин «сильный ИИ» как часть своего Китайская комната аргумент.[77] Он хотел различить две разные гипотезы об искусственном интеллекте:[78]

- Система искусственного интеллекта может считать и иметь разум. (Слово «разум» имеет особое значение для философов, оно используется в проблема разума и тела " или философия разума ".)

- Система искусственного интеллекта может (только) вести себя как он думает и имеет разум.

Первый называется " сильный Гипотеза ИИ », а вторая -« слабый Гипотеза ИИ », потому что первая делает сильнее Заявление: предполагается, что с машиной произошло что-то особенное, что выходит за рамки всех ее возможностей, которые мы можем проверить. Сирл назвал «гипотезу сильного ИИ» «сильным ИИ». Это использование также распространено в академических исследованиях ИИ и учебниках.[79]

Гипотеза слабого ИИ эквивалентна гипотезе о возможности искусственного интеллекта в целом. В соответствии с Рассел и Норвиг, «Большинство исследователей ИИ принимают гипотезу слабого ИИ как должное и не заботятся о сильной гипотезе ИИ».[80]

В отличие от Сёрла, Рэй Курцвейл использует термин "сильный ИИ" для описания любой системы искусственного интеллекта, которая действует как разум,[45] независимо от того, сможет ли философ определить, фактически есть разум или нет. В научной фантастике ОИИ ассоциируется с такими чертами, как сознание, разумность, разум, и самосознание наблюдается у живых существ. Однако, согласно Серлу, вопрос о том, достаточно ли общего интеллекта для сознания, остается открытым. «Сильный ИИ» (как определено выше Курцвейлом) не следует путать с ИИ Серла.сильная гипотеза ИИ. "Сильная гипотеза ИИ - это утверждение, что компьютер, который ведет себя так же разумно, как и человек, также обязательно должен иметь разум и сознание. AGI относится только к количеству интеллекта, который демонстрирует машина, с разумом или без него.

Сознание

Помимо интеллекта, существуют и другие аспекты человеческого разума, имеющие отношение к концепции сильного ИИ, которые играют важную роль в научная фантастика и этика искусственного интеллекта:

- сознание: Иметь субъективный опыт и мысль.[81]

- самосознание: Осознавать себя как отдельную личность, особенно осознавать собственные мысли.

- разумность: Способность «чувствовать» восприятие или эмоции субъективно.

- разум: Способность к мудрости.

Эти черты имеют моральное измерение, потому что машина с такой формой сильного ИИ может иметь права, аналогичные права животных, кроме человека. Таким образом, была проведена предварительная работа по подходам к интеграции полных этических агентов с существующими правовыми и социальными структурами. Эти подходы сосредоточены на правовом положении и правах «сильного» ИИ.[82]

Тем не мение, Билл Джой, среди прочего, утверждает, что машина с такими характеристиками может представлять угрозу для жизни или достоинства человека.[83] Остается показать, является ли какая-либо из этих черт необходимо для сильного ИИ. Роль сознание неясно, и в настоящее время нет согласованного теста на его присутствие. Если машина построена с устройством, имитирующим нейронные корреляты сознания будет ли у него самоосознание автоматически? Также возможно, что некоторые из этих свойств, такие как разум, естественно появляются от полностью интеллектуальной машины, или что становится естественным приписывать эти свойства для машин, когда они начинают действовать явно разумным образом. Например, разумного действия может быть достаточно для восприятия, а не наоборот.

Исследование искусственного сознания

Хотя роль сознания в сильном AI / AGI спорна, многие исследователи AGI[84] считают исследования, которые исследуют возможности реализации сознания, жизненно важными. На первых порах Игорь Александр[85] утверждал, что принципы создания сознательной машины уже существуют, но потребуется сорок лет, чтобы научить такую машину понимать язык.

Возможные объяснения медленного прогресса исследований ИИ

С момента начала исследований искусственного интеллекта в 1956 году рост этой области со временем замедлился и поставил в тупик цели создания машин, обладающих умными способностями к действию на человеческом уровне.[86] Возможное объяснение этой задержки заключается в том, что компьютерам не хватает памяти или вычислительной мощности.[86] Кроме того, уровень сложности, связанный с процессом исследования ИИ, также может ограничивать прогресс исследований ИИ.[86]

Хотя большинство исследователей ИИ считают, что сильный ИИ может быть достигнут в будущем, есть такие люди, как Хуберт Дрейфус и Роджер Пенроуз которые отрицают возможность достижения сильного ИИ.[86] Джон Маккарти был одним из различных компьютерных ученых, которые полагали, что ИИ на человеческом уровне будет совершен, но дату нельзя точно предсказать.[87]

Концептуальные ограничения - еще одна возможная причина медлительности исследований ИИ.[86] Исследователям ИИ может потребоваться изменить концептуальные рамки своей дисциплины, чтобы обеспечить более прочную основу и внести свой вклад в поиски сильного ИИ. Как писал Уильям Клоксин в 2003 году: «концепция начинается с наблюдения Вейценбаума о том, что интеллект проявляется только в определенных социальных и культурных контекстах».[86]

Кроме того, исследователи ИИ смогли создать компьютеры, которые могут выполнять работу, сложную для людей, такую как математика, но, наоборот, они изо всех сил пытались разработать компьютер, способный выполнять задачи, простые для выполнения людьми. например ходьба (Парадокс Моравца ).[86] Проблема, описанная Дэвидом Гелернтером, состоит в том, что некоторые люди считают мышление и рассуждение эквивалентными.[88] Однако идея о том, изолированы ли мысли и создатель этих мыслей индивидуально, заинтриговала исследователей ИИ.[88]

Проблемы, с которыми столкнулись исследования искусственного интеллекта за последние десятилетия, еще больше затруднили его развитие. Неудачные предсказания, обещанные исследователями ИИ, и отсутствие полного понимания человеческого поведения помогли принизить основную идею ИИ человеческого уровня.[46] Хотя прогресс исследований ИИ принес как улучшения, так и разочарования, большинство исследователей с оптимизмом смотрят на возможное достижение цели ИИ в 21 веке.[46]

Были предложены и другие возможные причины длительного исследования развития сильного ИИ. Сложность научных проблем и необходимость полного понимания человеческого мозга с помощью психологии и нейрофизиологии ограничивают многих исследователей в имитации функции человеческого мозга в компьютерном оборудовании.[89] Многие исследователи склонны недооценивать любые сомнения, связанные с будущими прогнозами ИИ, но, не принимая эти проблемы серьезно, люди могут упустить из виду решения проблемных вопросов.[46]

Клоксин говорит, что концептуальное ограничение, которое может препятствовать прогрессу исследований ИИ, заключается в том, что люди могут использовать неправильные методы для компьютерных программ и реализации оборудования.[86] Когда исследователи ИИ впервые начали стремиться к созданию искусственного интеллекта, их главным интересовало человеческое мышление.[90] Исследователи надеялись создать вычислительные модели человеческих знаний с помощью рассуждений и выяснить, как разработать компьютер для решения конкретной когнитивной задачи.[90]

Практика абстракции, которую люди склонны переопределять при работе с конкретным контекстом в исследовании, позволяет исследователям сосредоточиться всего на нескольких концепциях.[90] Наиболее продуктивное использование абстракции в исследованиях искусственного интеллекта происходит от планирования и решения проблем.[90] Хотя цель состоит в том, чтобы увеличить скорость вычислений, роль абстракции поставила вопросы об участии операторов абстракции.[91]

Возможная причина медлительности ИИ связана с признанием многими исследователями ИИ того, что эвристика - это раздел, который содержит значительный разрыв между производительностью компьютера и производительностью человека.[89] Конкретные функции, запрограммированные на компьютер, могут учитывать многие требования, которые позволяют ему соответствовать человеческому интеллекту. Эти объяснения не обязательно являются фундаментальными причинами задержки в достижении сильного ИИ, но они широко признаны многочисленными исследователями.

Многие исследователи искусственного интеллекта спорят о том, стоит ли машины должны создаваться с эмоциями. В типичных моделях ИИ нет эмоций, и некоторые исследователи говорят, что программирование эмоций в машинах позволяет им иметь собственное мышление.[86] Эмоции суммируют переживания людей, потому что они позволяют им помнить эти переживания.[88] Дэвид Гелернтер пишет: «Ни один компьютер не будет творческим, если не сможет моделировать все нюансы человеческих эмоций».[88] Это беспокойство по поводу эмоций создает проблемы для исследователей ИИ и связано с концепцией сильного ИИ по мере продвижения его исследований в будущее.[92]

Споры и опасности

Осуществимость

Эта секция нуждается в расширении. Вы можете помочь добавляя к этому. (Февраль 2016 г.) |

По состоянию на август 2020 года AGI остается спекулятивным[8][93] поскольку такая система еще не была продемонстрирована. Мнения расходятся как по ли и когда вообще появится искусственный интеллект. С одной стороны, пионер ИИ Герберт А. Саймон предположил в 1965 году: «В течение двадцати лет машины будут способны выполнять любую работу, которую может выполнять человек». Однако это предсказание не сбылось. Соучредитель Microsoft Пол Аллен считал, что такой интеллект маловероятен в 21 веке, потому что он потребует «непредвиденных и принципиально непредсказуемых прорывов» и «глубокого научного понимания познания».[94] Писать в Хранитель Робототехник Алан Уинфилд заявил, что пропасть между современными вычислениями и искусственным интеллектом человеческого уровня так же велика, как пропасть между текущим космическим полетом и практическим космическим полетом со скоростью, превышающей скорость света.[95]

Взгляды экспертов по ИИ на осуществимость AGI увеличиваются и уменьшаются, и, возможно, в 2010-х годах они возродились. Четыре опроса, проведенные в 2012 и 2013 годах, показали, что среднее предположение экспертов относительно того, когда они будут на 50% уверены в появлении AGI, составляет 2040–2050, в зависимости от опроса, при среднем значении 2081. Из экспертов 16,5% ответили « никогда », когда ему задают тот же вопрос, но с вероятностью 90%.[96][97] Дальнейшие текущие соображения о прогрессе AGI можно найти ниже. Тесты для подтверждения ОИИ человеческого уровня и IQ-тесты AGI.

Потенциальная угроза человеческому существованию

Тезис о том, что ИИ представляет собой риск для существования и что этот риск требует гораздо большего внимания, чем ему уделяется в настоящее время, был поддержан многими общественными деятелями; пожалуй, самые известные из них Илон Маск, Билл Гейтс, и Стивен Хокинг. Наиболее известным исследователем ИИ, поддержавшим тезис, является Стюарт Дж. Рассел. Сторонники тезиса иногда выражают недоумение скептикам: Гейтс заявляет, что он «не понимает, почему некоторые люди не обеспокоены»,[98] и Хокинг раскритиковал широко распространенное безразличие в своей передовой статье 2014 года:

«Итак, перед лицом возможных будущих неисчислимых выгод и рисков эксперты, несомненно, делают все возможное, чтобы обеспечить наилучший результат, верно? Неправильный. Если бы высшая инопланетная цивилизация отправила нам сообщение: «Мы прибудем через несколько десятилетий», мы бы просто ответили: «Хорошо, позвоните нам, когда доберетесь сюда - мы оставим свет включенным?» Наверное, нет - но это более или менее то, что происходит с ИИ ».[99]

Многие ученые, обеспокоенные риском для существования, считают, что лучшим путем вперед было бы провести (возможно, масштабное) исследование для решения трудных задач ».проблема управления «чтобы ответить на вопрос: какие типы защиты, алгоритмы или архитектуры могут реализовать программисты, чтобы максимизировать вероятность того, что их рекурсивно улучшающийся ИИ продолжит вести себя дружественным, а не разрушительным образом после того, как достигнет сверхразума?[100][101]

У тезиса о том, что ИИ может представлять опасность для жизни, также есть много сильных противников. Скептики иногда обвиняют этот тезис в крипторелигиозной иррациональной вере в возможность суперинтеллекта заменить иррациональную веру во всемогущего Бога; в крайнем случае, Джарон Ланье утверждает, что вся концепция, согласно которой нынешние машины в любом случае разумны, является «иллюзией» и «колоссальным обманом» богатых.[102]

Многие критики утверждают, что AGI маловероятен в краткосрочной перспективе. Специалист в области информатики Гордон Белл утверждает, что человечество уже уничтожит себя прежде, чем достигнет технологическая особенность. Гордон Мур, первоначальный сторонник Закон Мура, заявляет, что «Я скептик. Я не верю, что [технологическая сингулярность] может произойти, по крайней мере, в течение длительного времени. И я не знаю, почему я так чувствую».[103] Бывший Baidu Вице-президент и главный научный сотрудник Эндрю Нг утверждает, что экзистенциальный риск ИИ «похож на беспокойство о перенаселенности Марса, когда мы еще даже не ступили на планету».[104]

Учреждения, работающие на базе ИИ, могут преодолеть эти потенциальные угрозы человеческим ресурсам путем разработки кросс-функциональных стратегий, которые используют интегрированные знания, навыки и способности человека и ИИ при выполнении бизнес-функций, продвигаемых ИИ (например, прогнозирование мошенничества и оценка кредитных рисков в финансах, ИИ -прогнозирование и решение проблем в управлении производством и цепочками поставок, автоматическое прогнозирование покупательского поведения потребителей в маркетинге и принятие стратегических решений).[105]

Смотрите также

- Искусственный мозг

- Проблема управления AI

- Автоматизированное машинное обучение

- Инициатива BRAIN

- Китайский мозговой проект

- Элиэзер Юдковски

- Институт будущего человечества

- Общая игра

- Проект человеческого мозга

- Повышение интеллекта (IA), использование информационных технологий для увеличения человеческого интеллекта вместо создания внешнего автономного "AGI".

- Машинная этика

- Многозадачное обучение

- Ник Бостром

- Схема искусственного интеллекта

- Очертание трансгуманизма

- Суперинтеллект

- Синтетический интеллект

- Передача обучения

Примечания

- ^ Ходсон, Хэл (1 марта 2019 г.). «DeepMind и Google: битва за контроль над искусственным интеллектом». 1843. Получено 7 июля 2020.

AGI означает общий искусственный интеллект, гипотетическую компьютерную программу ...

- ^ Курцвейл, Сингулярность (2005) стр. 260

- ^ а б Курцвейл, Рэй (5 августа 2005 г.), "Да здравствует ИИ", Forbes: Курцвейл описывает сильный ИИ как «машинный интеллект с полным спектром человеческого интеллекта».

- ^ Тредер, Майк (10 августа 2005 г.), «Продвинутый человеческий интеллект», Ответственная нанотехнология, в архиве из оригинала 16 октября 2019 г.

- ^ «Эпоха искусственного интеллекта: Джордж Джон на TEDxLondonBusinessSchool 2013». В архиве из оригинала 26 февраля 2014 г.. Получено 22 февраля 2014.

- ^ Ньюэлл и Саймон 1976, Это термин, который они используют для обозначения интеллекта "человеческого уровня" в система физических символов гипотеза.

- ^ Сирл 1980, См. Ниже происхождение термина "сильный ИИ" и см. Академическое определение "сильный ИИ "в статье Китайская комната.

- ^ а б europarl.europa.eu: Как работает искусственный интеллект, «Заключительные замечания: сегодняшний ИИ - мощный и полезный, но он далек от спекуляций AGI или ASI». Европейская парламентская исследовательская служба, получено 3 марта 2020 г.

- ^ Грейс, Катя; Сальватье, Джон; Дефо, Аллан; Чжан, Баобао; Эванс, Оуайн (31 июля 2018 г.). «Точка зрения: когда ИИ превзойдет человеческие возможности? Данные экспертов по ИИ». Журнал исследований искусственного интеллекта. 62: 729–754. Дои:10.1613 / jair.1.11222. ISSN 1076-9757.

- ^ «Открытый университет сильного и слабого ИИ». Архивировано из оригинал 25 сентября 2009 г.. Получено 8 октября 2007.

- ^ а б c Баум, Сет (12 ноября 2017 г.). "Баум, Сет, Обзор проектов общего искусственного интеллекта с точки зрения этики, рисков и политики (12 ноября 2017 г.). Рабочий документ Института глобальных катастрофических рисков 17-1". Цитировать журнал требует

| журнал =(помощь) - ^ Основатель AI Джон Маккарти пишет: «мы еще не можем в целом охарактеризовать, какие вычислительные процедуры мы хотим назвать интеллектуальными». Маккарти, Джон (2007). «Основные вопросы». Стэндфордский Университет. В архиве из оригинала 26 октября 2007 г.. Получено 6 декабря 2007. (Для обсуждения некоторых определений интеллекта, используемых искусственный интеллект исследователи, см. философия искусственного интеллекта.)

- ^ Этот список интеллектуальных качеств основан на темах, охватываемых основными учебниками по ИИ, в том числе:Рассел и Норвиг, 2003 г.,Люгер и Стаблфилд 2004,Пул, Макворт и Гебель, 1998 г. иНильссон 1998.

- ^ Пфайфер Р. и Бонгард Дж. К. Как тело формирует образ нашего мышления: новый взгляд на интеллект (MIT Press, 2007). ISBN 0-262-16239-3

- ^ Уайт, Р. У. (1959). «Мотивация по-новому: понятие компетентности». Психологический обзор. 66 (5): 297–333. Дои:10,1037 / ч0040934. PMID 13844397.

- ^ Джонсон 1987

- ^ деЧармс, Р. (1968). Личная причинно-следственная связь. Нью-Йорк: Academic Press.

- ^ Мюльхаузер, Люк (11 августа 2013 г.). "Что такое AGI?". Научно-исследовательский институт машинного интеллекта. В архиве из оригинала 25 апреля 2014 г.. Получено 1 мая 2014.

- ^ «Что такое общий искусственный интеллект (AGI)? | 4 теста для обеспечения общего искусственного интеллекта». Talky Blog. 13 июля 2019. В архиве из оригинала 17 июля 2019 г.. Получено 17 июля 2019.

- ^ Шапиро, Стюарт С. (1992). Искусственный интеллект В архиве 1 февраля 2016 г. Wayback Machine В Стюарте С. Шапиро (ред.), Энциклопедия искусственного интеллекта (Второе издание, стр. 54–57). Нью-Йорк: Джон Вили. (Раздел 4 посвящен «Задачи, выполняемые AI».)

- ^ Роман В. Ямпольский. Тест Тьюринга как определяющий признак AI-полноты. В области искусственного интеллекта, эволюционных вычислений и метаэвристики (AIECM) - по стопам Алана Тьюринга. Синь-Шэ Ян (Ред.). С. 3–17. (Глава 1). Спрингер, Лондон. 2013. http://cecs.louisville.edu/ry/TuringTestasaDefiningFeature04270003.pdf В архиве 22 мая 2013 г. Wayback Machine

- ^ Луис фон Ан, Мануэль Блюм, Николас Хоппер и Джон Лэнгфорд. CAPTCHA: использование сложных задач ИИ для обеспечения безопасности В архиве 4 марта 2016 г. Wayback Machine. В Proceedings of Eurocrypt, Vol. 2656 (2003), стр. 294–311.

- ^ Бергмайр, Ричард (7 января 2006 г.). "Стеганография естественного языка и" ИИ-полный "примитив безопасности". CiteSeerX 10.1.1.105.129. Цитировать журнал требует

| журнал =(помощь) (не опубликовано?) - ^ Crevier 1993, стр. 48–50

- ^ Саймон 1965, п. 96 цитируется в Crevier 1993, п. 109

- ^ «Ученый на съемочной площадке: интервью с Марвином Мински». В архиве из оригинала 16 июля 2012 г.. Получено 5 апреля 2008.

- ^ Марвин Мински к Даррах (1970), цитируется в Кревье (1993, п. 109).

- ^ В Отчет Лайтхилла специально критиковал «грандиозные цели» ИИ и руководил свертыванием исследований ИИ в Англии. (Лайтхилл 1973; Хау 1994 ) В США., DARPA стали полны решимости финансировать только «прямые исследования, ориентированные на миссию, а не фундаментальные ненаправленные исследования». Видеть (NRC 1999 ) в разделе «Переход к прикладным исследованиям увеличивает инвестиции». Смотрите также (Crevier 1993, стр. 115–117). и (Рассел и Норвиг, 2003 г., стр. 21–22).

- ^ Crevier 1993, п. 211, Рассел и Норвиг, 2003 г., п. 24 и смотрите также Фейгенбаум и МакКордак, 1983 г.

- ^ Crevier 1993, стр. 161–162,197–203,240; Рассел и Норвиг, 2003 г., п. 25; NRC 1999 в разделе «Переход к прикладным исследованиям увеличивает инвестиции»

- ^ Crevier 1993, стр. 209–212

- ^ Как основатель ИИ Джон Маккарти пишет: «Для остальных сотрудников ИИ было бы большим облегчением, если бы изобретатели новых общих формализмов выразили бы свои надежды в более осторожной форме, чем это было иногда». Маккарти, Джон (2000). "Ответ Лайтхиллу". Стэндфордский Университет. В архиве из оригинала 30 сентября 2008 г.. Получено 29 сентября 2007.

- ^ «На самом низком уровне некоторые компьютерные ученые и инженеры-программисты избегали термина« искусственный интеллект », опасаясь, что их сочтут безумными мечтателями».Марков, Джон (14 октября 2005 г.). «За искусственным интеллектом стоит эскадрилья ярких реальных людей». Нью-Йорк Таймс.

- ^ Рассел и Норвиг, 2003 г., стр. 25–26

- ^ «Тенденции в цикле новых технологий». Отчеты Gartner. В архиве из оригинала 22 мая 2019 г.. Получено 7 мая 2019.

- ^ Моравец 1988, п. 20

- ^ Харнад, S (1990). «Проблема заземления символа». Physica D. 42 (1–3): 335–346. arXiv:cs / 9906002. Bibcode:1990 ФИД ... 42..335H. Дои:10.1016/0167-2789(90)90087-6.

- ^ Губруд 1997

- ^ «Кто придумал термин« ОИИ »?» Goertzel.org ». В архиве с оригинала 28 декабря 2018 г.. Получено 28 декабря 2018., через Жизнь 3.0: «Термин« AGI »популяризировали ... Шейн Легг, Марк Губруд и Бен Гертцель»

- ^ Герцель и Ван, 2006 г.. Смотрите также Ван (2006) с актуальным резюме и множеством ссылок.

- ^ https://goertzel.org/AGI_Summer_School_2009.htm

- ^ http://fmi-plovdiv.org/index.jsp?id=1054&ln=1

- ^ http://fmi.uni-plovdiv.bg/index.jsp?id=1139&ln=1

- ^ Герцель и Пенначин, 2006 г..

- ^ а б c (Курцвейл 2005, п. 260) или посмотреть Продвинутый человеческий интеллект В архиве 30 июня 2011 г. Wayback Machine где он определяет сильный ИИ как «машинный интеллект с полным спектром человеческого интеллекта».

- ^ а б c d е ж Гертцель 2007.

- ^ «Ошибка Армстронга и Соталы 2012». Воздействие ИИ. 2016 г.. Получено 24 августа 2020.

- ^ «Интеллектуальные машины, которые обучаются без посторонней помощи» (PDF). Тичино Рицерка. 2004 г.. Получено 24 августа 2020.

- ^ Марков, Джон (27 ноября 2016 г.). "Когда ИИ созревает, он может называть Юргена Шмидхубера папой"'". Нью-Йорк Таймс. В архиве из оригинала 26 декабря 2017 г.. Получено 26 декабря 2017.

- ^ Джеймс Баррат (2013). «Глава 11: Тяжелый взлет». Наше последнее изобретение: искусственный интеллект и конец человеческой эры (Первое изд.). Нью-Йорк: Издательство Св. Мартина. ISBN 9780312622374.

- ^ «О научно-исследовательском институте машинного интеллекта». Научно-исследовательский институт машинного интеллекта. В архиве из оригинала 21 января 2018 г.. Получено 26 декабря 2017.

- ^ «Об OpenAI». OpenAI. В архиве из оригинала 22 декабря 2017 г.. Получено 26 декабря 2017.

- ^ Тейл, Стефан. "Проблемы в разуме". Scientific American. С. 36–42. Bibcode:2015SciAm.313d..36T. Дои:10.1038 / Scientificamerican1015-36. В архиве из оригинала 9 ноября 2017 г.. Получено 26 декабря 2017.

- ^ Уолч, Кэтлин (16 октября 2020 г.). «Платформа общего искусственного интеллекта». Forbes.

Д-р Гертцель является основателем SingularityNET, децентрализованной платформы ИИ, которая позволяет нескольким агентам ИИ сотрудничать для решения проблем на основе участия без какого-либо центрального контроллера. ... Д-р Герцель создал SingularityNET по одной простой причине: «Я намерен создать AGI, и когда я разверну этот AGI, я хочу, чтобы он был развернут децентрализованным и демократически контролируемым способом, а не способом, который позволяет это сделать». должны контролироваться любым физическим, юридическим или государственным лицом ».

- ^ Лю, Фэн; Ши, Юн; Лю, Ин (2017). «Коэффициент интеллекта и уровень интеллекта искусственного интеллекта». Анналы науки о данных. 4 (2): 179–191. arXiv:1709.10242. Bibcode:2017arXiv170910242L. Дои:10.1007 / s40745-017-0109-0. S2CID 37900130.

- ^ "Google-KI doppelt so schlau wie Siri". В архиве из оригинала на 3 января 2019 г.. Получено 2 января 2019.

- ^ Лоулер, Ричард (13 ноября 2019 г.). «Джон Кармак делает шаг назад в Oculus, чтобы работать над человеческим ИИ». Engadget. Получено 4 апреля 2020.

- ^ Гроссман, Гэри (3 сентября 2020 г.). «Мы входим в сумеречную зону ИИ между узким и общим ИИ». VentureBeat. Получено 5 сентября 2020.

Конечно, есть и те, кто утверждает, что мы уже видим ранний пример системы AGI в недавно анонсированной нейронной сети обработки естественного языка (NLP) GPT-3. ... Так является ли GPT-3 первым примером системы AGI? Это спорно, но консенсус в том, что это не AGI. ... По крайней мере, GPT-3 говорит нам, что есть золотая середина между узким и общим ИИ.

- ^ Сандберг и Бострем, 2008 г.. «Основная идея состоит в том, чтобы взять конкретный мозг, детально просканировать его структуру и построить его программную модель, которая настолько верна оригиналу, что при запуске на соответствующем оборудовании она будет вести себя практически так же, как оригинал. мозг."

- ^ Сандберг и Бострем, 2008 г..

- ^ Драхман 2005.

- ^ Рассел и Норвиг, 2003 г..

- ^ В "Дети разума" Моравец 1988, п. 61 1015 cps используется. Совсем недавно, в 1997 году, <«Архивная копия». Архивировано из оригинал 15 июня 2006 г.. Получено 23 июн 2006.CS1 maint: заархивированная копия как заголовок (связь)> Моравец выступал за 108 MIPS, что примерно соответствует 1014 cps. Моравец использует термины MIPS, а не «cps», что является нестандартным термином, введенным Курцвейлом.

- ^ Сваминатан, Нихил (январь – февраль 2011 г.). «Глия - другие клетки мозга». Обнаружить. В архиве из оригинала 8 февраля 2014 г.. Получено 24 января 2014.

- ^ Ижикевич, Евгений М .; Эдельман, Джеральд М. (4 марта 2008 г.). «Крупномасштабная модель таламокортикальной системы млекопитающих» (PDF). PNAS. 105 (9): 3593–3598. Bibcode:2008PNAS..105.3593I. Дои:10.1073 / pnas.0712231105. ЧВК 2265160. PMID 18292226. Архивировано из оригинал (PDF) 12 июня 2009 г.. Получено 23 июн 2015.

- ^ "Основные этапы проекта". Синий мозг. Получено 11 августа 2008.

- ^ «Искусственный мозг через 10 лет», 2009 г. - новости BBC ». 22 июля 2009 г. В архиве из оригинала 26 июля 2017 г.. Получено 25 июля 2009.

- ^ Новости университета Калгари В архиве 18 августа 2009 г. Wayback Machine, Новости NBC News В архиве 4 июля 2017 г. Wayback Machine

- ^ «Архивная копия». Архивировано из оригинал 15 июня 2006 г.. Получено 23 июн 2006.CS1 maint: заархивированная копия как заголовок (связь)

- ^ де Вега, Гленберг и Грессер, 2008 г.. Широкий спектр взглядов в текущих исследованиях, все из которых в той или иной степени требуют обоснования.

- ^ "некоторые ссылки на исследования мозга пчел". Архивировано из оригинал 5 октября 2011 г.. Получено 30 марта 2010.

- ^ В книге Гертцельса AGI (Юдковский 2006 ), Юдковский предлагает 5 уровней организации, которые необходимо понять - код / данные, сенсорная модальность, концепция и категория, мысль и обдумывание (сознание) - чтобы использовать доступное оборудование.

- ^ Yekutieli, Y; Сагив-Зохар, Р; Ааронов, Р; Энгель, У; Hochner, B; Флэш, Т (август 2005 г.). «Динамическая модель руки осьминога. I. Биомеханика движения осьминога в движении». J. Neurophysiol. 94 (2): 1443–58. Дои:10.1152 / ян.00684.2004. PMID 15829594.

- ^ Уильямс и Херруп 1988

- ^ "нервная система, человек". Британская энциклопедия. 9 января 2007 г.

- ^ Азеведо и др. 2009 г..

- ^ Сирл 1980

- ^ Как определено в стандартном учебнике ИИ: «Утверждение о том, что машины могут действовать разумно (или, что лучше, действовать так, как если бы они были разумными), философы называют гипотезой« слабого ИИ », а утверждение, что машины, которые это делают, являются собственно мышление (в отличие от моделирования мышления) называется гипотезой «сильного ИИ» ". (Рассел и Норвиг, 2003 г. )

- ^ Например:

- Рассел и Норвиг, 2003 г.,

- Психологический словарь Oxford University Press В архиве 3 декабря 2007 г. Wayback Machine (цитируется в "Энциклопедии дальнего света"),

- Энциклопедия когнитивной науки Массачусетского технологического института В архиве 19 июля 2008 г. Wayback Machine (цитируется в "AITopics")

- Планета Математика В архиве 19 сентября 2007 г. Wayback Machine

- Смогут ли биологические компьютеры превратить машины с искусственным интеллектом в людей? В архиве 13 мая 2008 г. Wayback Machine Энтони Тонген

- ^ Рассел и Норвиг, 2003 г., п. 947.

- ^ Обратите внимание, что сознание сложно определить. Популярное определение из-за Томас Нагель, заключается в том, что это "похоже на" что-то осознанное. Если мы не в сознании, тогда это ни на что не похоже. Нагель использует пример летучей мыши: мы можем разумно спросить: «Каково это быть летучей мышью?» Однако вряд ли мы зададимся вопросом «каково быть тостером?» Нагель приходит к выводу, что летучая мышь кажется в сознании (то есть имеет сознание), а тостер - нет. Видеть (Нагель 1974 )

- ^ Сотала, Кадж; Ямпольский, Роман V (19 декабря 2014 г.). «Ответы на катастрофический риск ОИИ: обзор». Physica Scripta. 90 (1): 8. Дои:10.1088/0031-8949/90/1/018001. ISSN 0031-8949.

- ^ Радость, Билл (Апрель 2000 г.). «Почему мы не нужны будущему». Проводной.

- ^ Юдковский 2006.

- ^ Александр 1996.

- ^ а б c d е ж грамм час я Часы в 2003 году.

- ^ Маккарти 2003.

- ^ а б c d Гелернтер 2010.

- ^ а б Маккарти 2007.

- ^ а б c d Holte & Choueiry 2003.

- ^ Цукер 2003.

- ^ Каплан, Андреас; Haenlein, Майкл (2019). «Каплан Андреас и Хэляйн Майкл (2019) Siri, Siri, в моей руке: кто самый справедливый в стране? Об интерпретациях, иллюстрациях и значениях искусственного интеллекта». Бизнес-горизонты. 62: 15–25. Дои:10.1016 / j.bushor.2018.08.004.

- ^ itu.int: За гранью безумия?: гонка за общий искусственный интеллект «AGI представляет собой уровень власти, который на сегодняшний день прочно остается в сфере спекулятивной фантастики». 2 февраля 2018 г., получено 3 марта 2020 г.

- ^ Аллен, Пол. «Сингулярность не рядом». Обзор технологий MIT. Получено 17 сентября 2014.

- ^ Уинфилд, Алан. «Искусственный интеллект не превратится в монстра Франкенштейна». Хранитель. В архиве из оригинала 17 сентября 2014 г.. Получено 17 сентября 2014.

- ^ Раффи Хачадурян (23 ноября 2015 г.). «Изобретение судного дня: принесет ли нам искусственный интеллект утопию или разрушение?». Житель Нью-Йорка. В архиве из оригинала 28 января 2016 г.. Получено 7 февраля 2016.

- ^ Мюллер, В. К., & Бостром, Н. (2016). Будущий прогресс в области искусственного интеллекта: обзор мнения экспертов. В «Фундаментальные вопросы искусственного интеллекта» (стр. 555–572). Спрингер, Чам.

- ^ Роулинсон, Кевин. «Билл Гейтс из Microsoft настаивает на том, что ИИ представляет собой угрозу». Новости BBC. Получено 30 января 2015.

- ^ Стивен Хокинг: «Transcendence рассматривает значение искусственного интеллекта, но достаточно ли серьезно мы относимся к ИИ?'". Индепендент (Великобритания). Получено 3 декабря 2014.

- ^ Бостром, Ник (2014). Сверхразум: пути, опасности, стратегии (Первое изд.). ISBN 978-0199678112.

- ^ Кай Сотала; Роман Ямпольский (19 декабря 2014 г.).«Ответы на катастрофический риск AGI: обзор». Physica Scripta. 90 (1).

- ^ «Но что будет для меня концом человечества?». Атлантический океан. 9 мая 2014. Получено 12 декабря 2015.

- ^ "Светильники технологий обращаются к сингулярности". IEEE Spectrum: Новости технологий, инженерии и науки (СПЕЦИАЛЬНЫЙ ОТЧЕТ: ОСОБЕННОСТЬ). 1 июня 2008 г.. Получено 8 апреля 2020.

- ^ Шермер, Майкл (1 марта 2017 г.). «Апокалипсис AI». Scientific American. п. 77. Bibcode:2017SciAm.316c..77S. Дои:10.1038 / scientificamerican0317-77. Получено 27 ноября 2017.

- ^ Юнис, R.A.A .; Адель, Х. (2020). Стратегия искусственного интеллекта, HRM, ориентированная на творчество, и качество обмена знаниями: эмпирический анализ индивидуальной и организационной эффективности предприятий, использующих искусственный интеллект. Лондон, Соединенное Королевство: Материалы ежегодной международной конференции Британской академии менеджмента (BAM) 2020: инновации для устойчивого будущего. ISBN 978-0-9956413-3-4.

Рекомендации

- Халяль, Уильям Э. "Серия статей TechCast: Автоматизация мысли" (PDF). Архивировано из оригинал (PDF) 6 июня 2013 г.

- Александр, Игорь (1996), Невозможные умы, Всемирная научная издательская компания, ISBN 978-1-86094-036-1

- Омохундро, Стив (2008), Природа самоулучшающегося искусственного интеллекта, представленный и распространенный на Саммите Singularity 2007, Сан-Франциско, Калифорния.

- Сандберг, Андерс; Бострем, Ник (2008), Эмуляция всего мозга: дорожная карта (PDF), Технический отчет № 2008-3, Институт будущего человечества, Оксфордский университет, получено 5 апреля 2009

- Азеведо Ф.А., Карвалью Л.Р., Гринберг Л.Т. и др. (Апрель 2009 г.), «Равное количество нейронных и ненейронных клеток делает человеческий мозг изометрически увеличенным мозгом приматов», Журнал сравнительной неврологии, 513 (5): 532–41, Дои:10.1002 / cne.21974, PMID 19226510, получено 4 сентября 2013

- Берглас, Энтони (2008), Искусственный интеллект убьет наших внуков

- Чалмерс, Дэвид (1996), Сознательный разум, Oxford University Press.

- Clocksin, Уильям (август 2003 г.), «Искусственный интеллект и будущее», Философские труды Королевского общества A, 361 (1809): 1721–1748, Bibcode:2003RSPTA.361.1721C, Дои:10.1098 / rsta.2003.1232, PMID 12952683, S2CID 31032007.

- Кревье, Даниэль (1993), AI: бурные поиски искусственного интеллекта, Нью-Йорк, Нью-Йорк: BasicBooks, ISBN 0-465-02997-3

- Даррах, Брэд (20 ноября 1970 г.), «Познакомьтесь с Шейки, первым электронным человеком», Журнал Life, стр. 58–68.

- Драхман, Д. (2005), «Есть ли у нас лишний мозг?», Неврология, 64 (12): 2004–5, Дои:10.1212 / 01.WNL.0000166914.38327.BB, PMID 15985565, S2CID 38482114.

- Файгенбаум, Эдвард А.; МакКордак, Памела (1983), Пятое поколение: искусственный интеллект и компьютерный вызов Японии миру, Майкл Джозеф, ISBN 978-0-7181-2401-4

- Гелернтер, Дэвид (2010), Логика сновидений, Интернет и искусственное мышление, получено 25 июля 2010

- Герцель, Бен; Пенначин, Кассио, ред. (2006), Общий искусственный интеллект (PDF), Спрингер, ISBN 978-3-540-23733-4, заархивировано из оригинал (PDF) 20 марта 2013 г.

- Герцель, Бен; Ван, Пей (2006), Введение: аспекты общего искусственного интеллекта (PDF)

- Герцель, Бен (Декабрь 2007 г.), «Общий искусственный интеллект человеческого уровня и возможность технологической сингулярности: реакция на« Сингулярность близка »Рэя Курцвейла и критика Курцвейла Макдермоттом», Искусственный интеллект, 171 (18, Special Review Issue): 1161–1173, Дои:10.1016 / j.artint.2007.10.011, получено 1 апреля 2009.

- Губруд, Марк (ноябрь 1997 г.), «Нанотехнологии и международная безопасность», Пятая Форсайт-конференция по молекулярной нанотехнологии, получено 7 мая 2011

- Holte, RC; Choueiry, BY (2003), "Абстракция и переформулировка в искусственном интеллекте", Философские труды Королевского общества B, 358 (1435): 1197–1204, Дои:10.1098 / rstb.2003.1317, ЧВК 1693218, PMID 12903653.

- Хау, Дж. (Ноябрь 1994 г.), Искусственный интеллект в Эдинбургском университете: перспектива, получено 30 августа 2007

- Джонсон, Марк (1987), Тело в уме, Чикаго, ISBN 978-0-226-40317-5

- Курцвейл, Рэй (2005), Сингулярность близка, Viking Press

- Лайтхилл, профессор сэр Джеймс (1973), «Искусственный интеллект: общий обзор», Искусственный интеллект: бумажный симпозиум, Научно-исследовательский совет

- Люгер, Джордж; Стаблфилд, Уильям (2004), Искусственный интеллект: структуры и стратегии для решения сложных проблем (5-е изд.), The Benjamin / Cummings Publishing Company, Inc., стр.720, ISBN 978-0-8053-4780-7

- Маккарти, Джон (Октябрь 2007 г.), «Отсюда до ИИ человеческого уровня», Искусственный интеллект, 171 (18): 1174–1182, Дои:10.1016 / j.artint.2007.10.009.

- МакКордак, Памела (2004), Машины, которые думают (2-е изд.), Натик, Массачусетс: A. K. Peters, Ltd., ISBN 1-56881-205-1

- Моравец, Ганс (1976), Роль грубой силы в интеллекте, заархивировано из оригинал 3 марта 2016 г., получено 29 сентября 2007

- Моравец, Ганс (1988), Дети разума, Издательство Гарвардского университета

- Нагель (1974), "Каково быть летучей мышью" (PDF), Философский обзор, 83 (4): 435–50, Дои:10.2307/2183914, JSTOR 2183914.

- Ньюэлл, Аллен; Саймон, Х.А. (1963), «GPS: программа, имитирующая человеческую мысль», в Feigenbaum, E.A .; Фельдман, Дж. (Ред.), Компьютеры и мысль, Нью-Йорк: Макгроу-Хилл

- Ньюэлл, Аллен; Саймон, Х.А. (1976). «Информатика как эмпирическое исследование: символы и поиск». Коммуникации ACM. 19 (3): 113–126. Дои:10.1145/360018.360022.CS1 maint: ref = harv (связь)

- Нильссон, Нильс (1998), Искусственный интеллект: новый синтез, Издательство Морган Кауфманн, ISBN 978-1-55860-467-4

- Рассел, Стюарт Дж.; Норвиг, Питер (2003), Искусственный интеллект: современный подход (2-е изд.), Верхняя Сэдл-Ривер, Нью-Джерси: Prentice Hall, ISBN 0-13-790395-2

- NRC (1999), «Разработки в области искусственного интеллекта», Финансирование революции: государственная поддержка компьютерных исследований, Национальная академия прессы

- Пул, Дэвид; Макворт, Алан; Гебель, Рэнди (1998), Вычислительный интеллект: логический подход, Нью-Йорк: Oxford University Press.

- Сирл, Джон (1980), «Умы, мозги и программы» (PDF), Поведенческие науки и науки о мозге, 3 (3): 417–457, Дои:10.1017 / S0140525X00005756

- Саймон, Х.А. (1965), Форма автоматизации для мужчин и менеджмента, Нью-Йорк: Harper & Row

- Сазерленд, Дж. (1990), "Голографическая модель памяти, обучения и выражения", Международный журнал нейронных систем, 1–3: 256–267.

- Williams RW, Herrup K (1988), "Контроль числа нейронов", Ежегодный обзор нейробиологии, 11: 423–53, Дои:10.1146 / annurev.ne.11.030188.002231, PMID 3284447.

- де Вега, Мануэль; Гленберг, Артур; Грэссер, Артур, ред. (2008), Символы и воплощение: споры о значении и познании, Издательство Оксфордского университета, ISBN 978-0-19-921727-4

- Юдковский, Элиэзер (2006), Герцель, Бен; Пенначин, Кассио (ред.), «Общий искусственный интеллект» (PDF), Ежегодный обзор психологии, Спрингер, 49: 585–612, Дои:10.1146 / annurev.psych.49.1.585, ISBN 978-3-540-23733-4, PMID 9496632, заархивировано из оригинал (PDF) 11 апреля 2009 г.

- Цукер, Жан-Даниэль (июль 2003 г.), «Обоснованная теория абстракции в искусственном интеллекте», Философские труды Королевского общества B, 358 (1435): 1293–1309, Дои:10.1098 / rstb.2003.1308, ЧВК 1693211, PMID 12903672.

- Юдковский, Элиэзер (2008 г.), «Искусственный интеллект как положительный и отрицательный фактор глобального риска», Глобальные катастрофические риски, Bibcode:2008gcr..book..303Y.

внешняя ссылка

- Портал AGI, поддерживаемый Пей Ван

- Genesis Group в CSAIL Массачусетского технологического института - Современные исследования вычислений, лежащих в основе человеческого интеллекта.

- OpenCog - проект с открытым исходным кодом для разработки ИИ человеческого уровня

- Моделирование логической человеческой мысли

- Что мы знаем о графиках работы ИИ? - Литературный обзор