Философия искусственного интеллекта - Philosophy of artificial intelligence

| Часть серии по |

| Искусственный интеллект |

|---|

Технологии |

Глоссарий |

Искусственный интеллект имеет тесные связи с философия потому что оба используют понятия с одинаковыми названиями, включая интеллект, действие, сознание, эпистемология, и даже свободная воля.[1] Кроме того, технология связана с созданием искусственных животных или искусственных людей (или, по крайней мере, искусственных существ; см. искусственная жизнь ), поэтому эта дисциплина представляет значительный интерес для философов.[2] Эти факторы способствовали появлению философия искусственного интеллекта. Некоторые ученые утверждают, что игнорирование философии сообществом ИИ пагубно.[3]

Философия искусственного интеллекта пытается ответить на такие вопросы следующим образом:[4]

- Может ли машина действовать разумно? Может ли это решить любой проблема, которую человек решит мысленно?

- Человеческий интеллект и машинный интеллект - это одно и то же? Это человеческий мозг по сути компьютер?

- Может ли машина иметь разум, психические состояния и сознание в том же смысле, что и человек? Может это почувствуй, как дела?

Подобные вопросы отражают различные интересы Исследователи ИИ, когнитивные ученые и философы соответственно. Научные ответы на эти вопросы зависят от определения понятий «интеллект» и «сознание» и от того, какие именно «машины» обсуждаются.

Важный предложения В философию ИИ можно отнести следующее:

- «Вежливое соглашение» Тьюринга: Если машина ведет себя так же разумно, как человек, то она так же разумна, как человек.[5]

- В Предложение Дартмута: «Каждый аспект обучения или любая другая особенность интеллекта может быть описана с такой точностью, что можно создать машину для его моделирования».[6]

- Аллен Ньюэлл и Герберт А. Саймон с система физических символов Гипотеза: «Физическая система символов имеет необходимые и достаточные средства общего разумного действия».[7]

- Джон Сирл с сильная гипотеза ИИ: «Правильно запрограммированный компьютер с правильными входами и выходами, таким образом, будет иметь разум точно так же, как и человеческие существа».[8]

- Гоббс механизм: «Потому что« разум »... это не что иное, как« расчет », то есть сложение и вычитание последствий общих названий, согласованных для« маркировки »и« обозначения »наших мыслей ...»[9]

Может ли машина показать общий интеллект?

Можно ли создать машину, которая сможет решать все проблемы, которые люди решают с помощью своего интеллекта? Этот вопрос определяет объем того, что машины могут делать в будущем, и определяет направление исследований ИИ. Это касается только поведение машин и игнорирует интересующие психологи, когнитивные ученые и философы; чтобы ответить на этот вопрос, не имеет значения, В самом деле думает (как думает человек) или просто действуя как это думает.[10]

Основная позиция большинства исследователей искусственного интеллекта резюмируется в этом заявлении, которое появилось в предложении по Дартмутская мастерская 1956 г .:

- «Каждый аспект обучения или любая другая особенность интеллекта может быть описана с такой точностью, что можно создать машину для его моделирования».[6]

Аргументы против основной посылки должны показать, что создание работающей системы ИИ невозможно, потому что есть некоторый практический предел возможностей компьютеров или что есть какое-то особое качество человеческого разума, которое необходимо для разумного поведения и, тем не менее, не может быть воспроизведено с помощью машина (или методами текущего исследования ИИ). Аргументы в пользу основной посылки должны показать, что такая система возможна.

Также можно обойти связь между двумя частями вышеуказанного предложения. Например, машинное обучение, начиная с печально известного Тьюринга. детская машина предложение[11] по сути, достигает желаемой функции интеллекта без точного описания во время разработки того, как именно это будет работать. Отчет о неявных знаниях робота[12] устраняет необходимость в точном описании.

Первый шаг к ответу на вопрос - дать четкое определение «интеллекта».

Интеллект

Тест Тьюринга

Алан Тьюринг[14] свел проблему определения интеллекта к простому вопросу о разговоре. Он предлагает следующее: если машина может ответить любой Если задать ей вопрос, используя те же слова, что и обычный человек, то мы можем назвать эту машину интеллектуальной. Современная версия его экспериментального проекта будет использовать онлайн чат-комната, где один из участников - реальное лицо, а один из участников - компьютерная программа. Программа проходит проверку, если никто не может сказать, кто из двух участников - человек.[5] Тьюринг отмечает, что никто (кроме философов) никогда не задает вопрос «могут ли люди думать?» Он пишет: «Вместо того, чтобы постоянно спорить по этому поводу, обычно принято вежливое соглашение, о котором все думают».[15] Тест Тьюринга распространяет это вежливое соглашение на машины:

- Если машина действует так же разумно, как человек, то она так же разумна, как и человек.

Одна критика Тест Тьюринга состоит в том, что он измеряет только «человечность» поведения машины, а не «интеллект» поведения. Поскольку человеческое поведение и разумное поведение - не одно и то же, тест не может измерить интеллект. Стюарт Дж. Рассел и Питер Норвиг пишут, что «тексты по авиационной инженерии не определяют цель своей области как« создание машин, которые летают так точно, как голуби, что они могут обмануть других голубей »».[16]

Определение интеллектуального агента

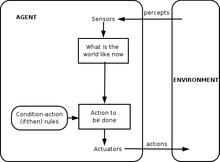

Исследования ИИ XXI века определяют интеллект с точки зрения интеллектуальные агенты. «Агент» - это то, что воспринимает окружающую среду и действует в ней. «Показатель производительности» определяет, что считается успехом для агента.[17]

- «Если агент действует так, чтобы максимизировать ожидаемое значение показателя производительности, основанного на прошлом опыте и знаниях, тогда он умный».[18]

Подобные определения пытаются уловить сущность интеллекта. У них есть то преимущество, что, в отличие от теста Тьюринга, они также не проверяют неразумные человеческие черты, такие как печатные ошибки.[19] или возможность быть оскорбленным.[20]У них есть недостаток, заключающийся в том, что они не умеют различать «вещи, которые думают» и «вещи, которые не умеют». Согласно этому определению, даже термостат имеет элементарный интеллект.[21]

Аргументы, что машина может показывать общий интеллект

Мозг можно смоделировать

Хуберт Дрейфус описывает этот аргумент как утверждение, что «если нервная система подчиняется законам физики и химии, а у нас есть все основания предполагать, что она подчиняется, то ... мы ... должны быть в состоянии воспроизвести поведение нервной системы. с каким-то физическим устройством ".[22] Этот аргумент, впервые представленный еще в 1943 г.[23] и ярко описано Ганс Моравец в 1988 г.,[24] теперь ассоциируется с футуристом Рэй Курцвейл, который считает, что мощности компьютера будет достаточно для полного моделирования мозга к 2029 году.[25] Моделирование таламокортикальной модели, которая имеет размер человеческого мозга, не в режиме реального времени (1011 нейронов) проведено в 2005 г.[26] и потребовалось 50 дней, чтобы смоделировать 1 секунду динамики мозга на кластере из 27 процессоров.

Несколько[количественно оценить ] не согласны с тем, что моделирование мозга теоретически возможно,[нужна цитата ][согласно кому? ] даже критики ИИ, такие как Хуберт Дрейфус и Джон Сирл.[27]Однако Сирл отмечает, что в принципе что-либо можно моделировать на компьютере; таким образом, доведение определения до критической точки приводит к выводу, что любой процесс вообще может технически считаться «вычислением». «Мы хотели знать, что отличает разум от термостатов и печени», - пишет он.[28] Таким образом, простое копирование функционирования мозга само по себе было бы признанием незнания интеллекта и природы разума.[нужна цитата ].

Человеческое мышление - это обработка символов

В 1963 г. Аллен Ньюэлл и Герберт А. Саймон предположил, что «манипулирование символами» было сущностью человеческого и машинного интеллекта. Они написали:

- «Физическая система символов имеет необходимые и достаточные средства для общего разумного действия».[7]

Это утверждение очень сильное: оно подразумевает, что человеческое мышление является разновидностью манипуляции символами (поскольку система символов необходимо для интеллекта) и что машины могут быть умными (потому что система символов достаточный для интеллекта).[29]Другой вариант этой позиции был описан философом Хубертом Дрейфусом, который назвал ее «психологическим допущением»:

- «Разум можно рассматривать как устройство, работающее с битами информации в соответствии с формальными правилами».[30]

«Символы», которые обсуждали Ньюэлл, Саймон и Дрейфус, были словесными и высокоуровневыми - символами, которые напрямую соотносятся с объектами в мире, такими как <собака> и <хвост>. Большинство программ ИИ, написанных между 1956 и 1990 годами, использовали этот вид символа. Современный ИИ, основанный на статистике и математической оптимизации, не использует высокоуровневую «обработку символов», о которой говорили Ньюэлл и Саймон.

Аргументы против обработки символов

Эти аргументы показывают, что человеческое мышление не состоит (исключительно) из высокоуровневых манипуляций с символами. Они делают нет показать, что искусственный интеллект невозможен, требуется только обработка символов.

Гёделевские антимеханистские аргументы

В 1931 г. Курт Гёдель доказано с теорема о неполноте что всегда можно построить "Гёделевский утверждение "что данный последовательный формальная система логики (например, высокоуровневой программы манипулирования символами) доказать не удалось. Несмотря на то, что это истинное утверждение, построенное утверждение Гёделя недоказуемо в данной системе. (Истинность сконструированного утверждения Гёделя зависит от непротиворечивости данной системы; применение того же процесса к слегка несовместимой системе будет казаться успешным, но фактически вместо этого даст ложное «утверждение Гёделя».)[нужна цитата ] Говоря более умозрительно, Гедель предположил, что человеческий разум может в конечном итоге правильно определить истинность или ложность любого хорошо обоснованного математического утверждения (включая любое возможное утверждение Гёделя), и что, следовательно, сила человеческого разума не сводится к механизм.[31] Философ Джон Лукас (с 1961 г.) и Роджер Пенроуз (с 1989 г.) отстаивают этот философский антимеханистский аргумент.[32] Геделианские антимеханистские аргументы имеют тенденцию полагаться на кажущееся безобидным утверждение, что система математиков-людей (или некоторая идеализация математиков-людей) одновременно последовательна (полностью свободна от ошибок) и полностью верит в свою собственную непротиворечивость (и может сделать все логичными). выводы, которые следуют из его собственной последовательности, включая веру в его утверждение Гёделя)[нужна цитата ]. Это доказуемо невозможно для машины Тьюринга.[требуется разъяснение ] (и, неофициально, любой известный тип механического компьютера) делать; поэтому гёделевцы заключает, что человеческое мышление слишком мощно, чтобы его можно было уловить в машине.[сомнительный ].

Однако современное мнение в научном и математическом сообществе состоит в том, что реальные человеческие рассуждения непоследовательны; что любая последовательная "идеализированная версия" ЧАС человеческого рассуждения было бы логически вынуждено принять здоровый, но противоречащий интуиции и непредвзятый скептицизм по поводу последовательности ЧАС (иначе ЧАС доказуемо несовместимо); и что теоремы Гёделя не приводят ни к какому действительному аргументу о том, что люди обладают способностями к математическому мышлению, превосходящими то, что машина могла бы когда-либо воспроизвести.[33][34][35] Этот консенсус о том, что гёделевские антимеханистские аргументы обречены на провал, четко сформулирован в Искусственный интеллект: "любой попытаться использовать (результаты Гёделя о неполноте), чтобы атаковать вычислитель тезис неизбежно будет незаконным, так как эти результаты вполне согласуются с тезисом вычислительной техники ".[36]

Более прагматично, Рассел и Норвиг отмечают, что аргумент Гёделя применим только к тому, что может быть доказано теоретически с учетом бесконечного количества памяти и времени. На практике реальные машины (включая людей) имеют ограниченные ресурсы, и им будет сложно доказать многие теоремы. Необязательно все доказывать, чтобы быть умным[когда определяется как? ].[37]

Менее формально, Дуглас Хофштадтер, в его Пулитцеровская премия книга-победитель Гедель, Эшер, Бах: вечная золотая коса, утверждает, что эти «утверждения Гёделя» всегда относятся к самой системе, проводя аналогию с тем, как Парадокс Эпименида использует утверждения, которые относятся к себе, например «это утверждение ложно» или «я лгу».[38] Но, конечно, Парадокс Эпименида применяется ко всему, что делает заявления, будь то машины или же люди, даже сам Лукас. Учитывать:

- Лукас не может подтвердить истинность этого утверждения.[39]

Это утверждение верно, но Лукас не может его утверждать. Это показывает, что сам Лукас подвержен тем же ограничениям, которые он описывает для машин, как и все люди, и поэтому Лукас Рассуждения бессмысленны.[40]

После того, как вывод, что человеческое мышление не является вычислимым, Пенроуз продолжал спорно предположить, что какое-то гипотетические невычислимых процессы, связанных с коллапс квантово-механический государства дают людям особое преимущество перед существующими компьютерами. Существующие квантовые компьютеры способны только снизить сложность вычислимых по Тьюрингу задач и по-прежнему ограничены задачами в рамках машин Тьюринга.[нужна цитата ][требуется разъяснение ]. По аргументам Пенроуза и Лукаса существующих квантовых компьютеров недостаточно.[нужна цитата ][требуется разъяснение ][Почему? ], поэтому Пенроуз ищет какой-то другой процесс, включающий новую физику, например квантовую гравитацию, которая могла бы проявить новую физику в масштабе Планковская масса через спонтанный квантовый коллапс волновой функции. Он предположил, что эти состояния возникают как внутри нейронов, так и охватывают более одного нейрона.[41] Однако другие ученые отмечают, что в мозге нет правдоподобного органического механизма для использования каких-либо квантовых вычислений, и, кроме того, временная шкала квантовой декогеренции кажется слишком быстрой, чтобы влиять на срабатывание нейронов.[42]

Дрейфус: примат неявных навыков

Хуберт Дрейфус утверждал, что человеческий интеллект и опыт зависел в первую очередь от неявных навыков, а не явных символических манипуляций, и утверждал, что эти навыки никогда не будут отражены в формальных правилах.[43]

Дрейфус аргумент был предвосхищен Тьюрингом в его статье 1950 г. Вычислительная техника и интеллект, где он классифицировал это как «аргумент из неформальности поведения».[44] Тьюринг в ответ утверждал, что то, что мы не знаем правил, управляющих сложным поведением, не означает, что таких правил не существует. Он писал: «Мы не можем так легко убедить себя в отсутствии полных законов поведения ... Единственный известный нам способ найти такие законы - это научное наблюдение, и мы, конечно, не знаем никаких обстоятельств, при которых мы могли бы сказать:« Мы достаточно искали. Таких законов нет ».[45]

Рассел и Норвиг отмечают, что за годы, прошедшие с тех пор, как Дрейфус опубликовал свою критику, был достигнут прогресс в открытии «правил», управляющих бессознательным рассуждением.[46] В расположенный движение в робототехника исследование пытается уловить наши бессознательные навыки восприятия и внимания.[47] Вычислительный интеллект парадигмы, такие как нейронные сети, эволюционные алгоритмы и так далее, в основном направлены на моделирование бессознательного мышления и обучения. Статистические подходы к ИИ может делать прогнозы, приближающиеся к точности интуитивных предположений человека. Исследования в здравый смысл был сосредоточен на воспроизведении «фона» или контекста знаний. Фактически, исследования ИИ в целом отошли от манипулирования символами высокого уровня к новым моделям, которые предназначены для того, чтобы охватить больше наших без сознания рассуждения.[46] Историк и исследователь ИИ Даниэль Кревье писали, что «время доказало точность и проницательность некоторых комментариев Дрейфуса. Если бы он сформулировал их менее агрессивно, конструктивные действия, которые они предлагали, могли быть предприняты гораздо раньше».[48]

Может ли машина иметь разум, сознание и психические состояния?

Это философский вопрос, связанный с проблема других умов и трудная проблема сознания. Вопрос вращается вокруг позиции, определенной Джон Сирл как «сильный ИИ»:

- Система физических символов может иметь разум и психические состояния.[8]

Сирл отличал эту позицию от того, что он называл «слабым ИИ»:

- Система физических символов может действовать разумно.[8]

Сирл ввел термины для отделения сильного ИИ от слабого, чтобы он мог сосредоточиться на том, что, по его мнению, было более интересным и спорным вопросом. Он утверждал, что даже если мы предположим что у нас есть компьютерная программа, которая действует точно так же, как человеческий разум, все равно остается сложный философский вопрос, на который необходимо ответить.[8]

Ни одна из двух позиций Серла не имеет большого значения для исследований ИИ, поскольку они не дают прямого ответа на вопрос «может ли машина отображать общий интеллект?» (если также нельзя показать, что сознание необходимо для интеллекта). Тьюринг писал: «Я не хочу производить впечатление, будто я думаю, что в сознании нет никакой тайны… [b] но я не думаю, что эти тайны обязательно нужно разгадывать, прежде чем мы сможем ответить на вопрос [могут ли машины думать]. "[49] Рассел и Норвиг соглашаются: «Большинство исследователей ИИ принимают гипотезу слабого ИИ как должное и не заботятся о сильной гипотезе ИИ».[50]

Есть несколько исследователей, которые считают, что сознание является важным элементом интеллекта, например: Игорь Александр, Стэн Франклин, Рон Сан, и Пентти Хайконен, хотя их определение «сознания» очень близко к «разуму». (Видеть искусственное сознание.)

Прежде чем мы сможем ответить на этот вопрос, мы должны четко понимать, что мы подразумеваем под «умами», «ментальными состояниями» и «сознанием».

Сознание, умы, психические состояния, значение

Слова "разум " и "сознание "используются разными сообществами по-разному. Некоторые новый век мыслители, например, используют слово «сознание», чтобы описать нечто подобное Бергсон "s"élan vital ": невидимая энергетическая жидкость, пронизывающая жизнь и особенно разум. Научная фантастика писатели используют это слово для описания некоторых существенный свойство, которое делает нас людьми: машина или инопланетянин, который «сознателен», будет представлен как полностью человеческий персонаж, с разумом, желаниями, буду, проницательность, гордость и так далее. (Писатели-фантасты также используют слова «разум», «разум», «самосознание» или «призрак " - как в Призрак в доспехах манга и аниме-сериалы - для описания этого важнейшего свойства человека). Для других[ВОЗ? ], слова «разум» или «сознание» используются как своего рода светский синоним душа.

За философы, нейробиологи и когнитивные ученые, слова используются более точным и приземленным образом: они относятся к привычному повседневному опыту наличия «мысли в голове», такой как восприятие, сон, намерение или план, и как мы знать что-то, или иметь в виду что-то или понимать что нибудь[нужна цитата ]. «Нетрудно дать здравое определение сознания», - замечает философ Джон Сирл.[51] Что загадочного и увлекательного не так уж и много Какие это но как это: как кусок жировой ткани и электричества дает начало этому (знакомому) опыту восприятия, значения или мышления?

Философы назовите это трудная проблема сознания. Это последняя версия классической задачи в философия разума называется "проблема разума и тела."[52] Связанная проблема - проблема смысл или же понимание (который философы называют "преднамеренность "): какова связь между нашими мысли и о чем мы думаем (т.е. объекты и ситуации в мире)? Третья проблема - проблема опыт (или же "феноменология "): Если два человека видят одно и то же, испытывают ли они одинаковый опыт? Или есть вещи" внутри их головы "(называемые"квалиа ") что может отличаться от человека к человеку?[53]

Нейробиологи верю, что все эти проблемы будут решены, когда мы начнем определять нейронные корреляты сознания: действительная взаимосвязь между механизмами в наших головах и их коллективными свойствами; такие как ум, опыт и понимание. Некоторые из самых резких критиков искусственный интеллект согласны с тем, что мозг - это просто машина, а сознание и интеллект являются результатом физических процессов в мозге.[54] Сложный философский вопрос заключается в следующем: может ли компьютерная программа, работающая на цифровой машине, которая перемешивает двоичные цифры нуля и единицы, дублировать способность нейроны создавать умы с ментальными состояниями (такими как понимание или восприятие) и, в конечном итоге, переживанием сознание ?

Аргументы о том, что компьютер не может иметь разум и психические состояния

Китайская комната Сирла

Джон Сирл просит нас рассмотреть мысленный эксперимент: предположим, мы написали компьютерную программу, которая проходит тест Тьюринга и демонстрирует общие разумные действия. Предположим, конкретно, что программа может свободно разговаривать на китайском языке. Напишите программу на карточках 3х5 и отдайте их обычному человеку, не владеющему китайским языком. Заприте человека в комнате и попросите его следовать инструкциям на карточках. Он будет копировать китайские иероглифы и передавать их в комнату и выходить через щель. Со стороны может показаться, что в китайской комнате находится полностью умный человек, говорящий по-китайски. Вопрос в следующем: есть ли в комнате кто-нибудь (или что-нибудь), кто понимает китайский? То есть есть ли что-нибудь, что имеет психическое состояние понимание, или который имеет сознательный осведомленность о чем идет речь на китайском? Мужчина явно не в курсе. Комната не может знать. В открытки конечно не в курсе. Сёрл приходит к выводу, что Китайская комната, или же любой другая физическая система символов, не может иметь разума.[55]

Сирл продолжает утверждать, что действительные психические состояния и сознание требуют (еще предстоит описать) «реальные физико-химические свойства реального человеческого мозга».[56] Он утверждает, что существуют особые "причинные свойства" мозги и нейроны что дает начало умы: по его словам «мозги вызывают умы».[57]

Связанные аргументы: мельница Лейбница, телефонная станция Дэвиса, китайская нация Блока и Болван.

Готфрид Лейбниц выдвинул по сути те же аргументы, что и Сирл в 1714 году, используя мысленный эксперимент по расширению мозга до размеров мельница.[58] В 1974 г. Лоуренс Дэвис представили дублирование мозга с помощью телефонных линий и офисов, укомплектованных людьми, а в 1978 году Нед Блок представил, что все население Китая будет вовлечено в такую симуляцию мозга. Этот мысленный эксперимент называется «Китайская нация» или «Китайский спортзал».[59] Нед Блок также предложил свою Аргумент болвана, который является версией Китайская комната в котором программа была реорганизованный в простой набор правил в форме «смотри это, делай то», устраняющий всю тайну из программы.

Отзывы о китайской комнате

Отзывы о китайской комнате подчеркивают несколько разных моментов.

- Системы отвечают и ответ виртуального разума:[60] Этот ответ утверждает, что система, включая человека, программу, комнату и карты - вот что понимает по-китайски. Сирл утверждает, что мужчина в комнате - единственное, что могло бы «иметь разум» или «понимать», но другие не соглашаются, утверждая, что это возможно. два разум в одном и том же физическом месте, подобно тому, как компьютер может одновременно "быть" двумя машинами одновременно: одна физическая (например, Macintosh ) и один "виртуальный " (как текстовый редактор ).

- Скорость, мощность и сложность ответов:[61] Некоторые критики отмечают, что человеку в комнате, вероятно, потребуются миллионы лет, чтобы ответить на простой вопрос, и ему потребуются «шкафы для хранения документов» астрономических размеров. Это ставит под сомнение ясность интуиции Сирла.

- Ответ робота:[62] Некоторые считают, что для того, чтобы по-настоящему понять, Китайской комнате нужны глаза и руки. Ганс Моравек пишет: «Если бы мы могли привить робота к программе рассуждений, нам больше не нужен был бы человек, который бы передавал смысл: он пришел бы из физического мира».[63]

- Ответ симулятора мозга:[64] Что, если программа имитирует последовательность нервных импульсов в синапсах реального мозга говорящего по-китайски? Мужчина в комнате имитировал настоящий мозг. Это вариант «системного ответа», который кажется более правдоподобным, потому что «система» теперь явно работает как человеческий мозг, что усиливает интуицию о том, что помимо человека в комнате есть что-то, что может понимать китайский язык.

- Другие умы отвечают и эпифеномены ответ:[65] Некоторые люди отметили, что аргумент Сирла - это всего лишь версия проблема других умов, применительно к машинам. Поскольку трудно определить, думают ли люди «на самом деле», не следует удивляться тому, что трудно ответить на тот же вопрос о машинах.

- С этим связан вопрос, существует ли «сознание» (как его понимает Сирл). Сирл утверждает, что переживание сознания нельзя обнаружить, исследуя поведение машины, человека или любого другого животного. Дэниел Деннетт указывает, что естественный отбор не может сохранить свойство животного, которое не влияет на поведение животного, и, следовательно, сознание (как его понимает Сирл) не может быть произведено естественным отбором. Следовательно, либо естественный отбор не породил сознание, либо «сильный ИИ» верен в том смысле, что сознание может быть обнаружено с помощью соответственно разработанного теста Тьюринга.

Мышление - это своего рода вычисление?

В вычислительная теория разума или же "вычислитель "утверждает, что отношения между разумом и мозгом аналогичны (если не идентичны) отношениям между запущенная программа и компьютер. Идея имеет философские корни в Гоббс (который утверждал, что рассуждение было «не более чем расчетом»), Лейбниц (который попытался создать логическое исчисление всех человеческих идей), Юм (кто думал, что восприятие может быть сведено к «атомарным впечатлениям») и даже Кант (которые проанализировали весь опыт как контролируемый формальными правилами).[66] Последняя версия связана с философами Хилари Патнэм и Джерри Фодор.[67]

Этот вопрос связан с нашими предыдущими вопросами: если человеческий мозг - это разновидность компьютера, то компьютеры могут быть как разумными, так и сознательными, отвечая как на практические, так и на философские вопросы ИИ. Что касается практического вопроса об ИИ («Может ли машина проявлять общий интеллект?»), Некоторые версии вычислительной техники утверждают, что (поскольку Гоббс написал):

- Рассуждение - это не что иное, как расчет.[9]

Другими словами, наш интеллект происходит от расчет, похожий на арифметика. Это система физических символов Гипотеза обсуждалась выше, и из нее следует, что искусственный интеллект возможен. Что касается философского вопроса об ИИ («Может ли машина иметь разум, психические состояния и сознание?»), Большинство версий вычислитель утверждают, что (как Стеван Харнад характеризует его):

- Психические состояния - это просто реализация (правильных) компьютерных программ.[68]

Это "сильный ИИ" Джона Сирла, о котором говорилось выше, и это настоящая цель Китайская комната аргумент (согласно Харнад ).[68]

Может ли машина вызывать эмоции?

Если "эмоции "определены только с точки зрения их влияния на поведение или как они функция внутри организма эмоции можно рассматривать как механизм, интеллектуальный агент использует для максимизации полезность его действий. Учитывая это определение эмоции, Ганс Моравец считает, что «роботы в целом будут довольно эмоциональны, когда будут хорошими людьми».[69] Страх - источник срочности. Сочувствие - необходимая составляющая хорошего взаимодействие человека с компьютером. Он говорит, что роботы «будут пытаться доставить вам удовольствие, явно самоотверженно, потому что они будут получать удовольствие от этого положительного подкрепления. Вы можете интерпретировать это как своего рода любовь».[69] Даниэль Кревье пишет: «Точка зрения Моравека состоит в том, что эмоции - это всего лишь средства для направления поведения в направлении, благоприятном для выживания вида».[70]

Может ли машина осознавать себя?

"Самосознание ", как отмечалось выше, иногда используется научная фантастика писатели как название для существенный человеческое свойство, делающее персонажа полностью человечным. Тьюринг отбрасывает все другие свойства человека и сводит вопрос к следующему: «Может ли машина быть предметом собственной мысли?» Может это думать о себе? С этой точки зрения можно написать программу, которая может сообщать о своих внутренних состояниях, например отладчик.[71] Хотя, возможно, самосознание часто предполагает немного больше возможностей; машина, которая может каким-то образом приписывать смысл не только своему собственному состоянию, но и в целом постулировать вопросы без твердых ответов: контекстуальная природа своего существования сейчас; как он сравнивается с прошлыми состояниями или планами на будущее, с ограничениями и ценностью своего рабочего продукта, как он воспринимает свою работу, чтобы ее оценили или сравнили с другими.

Машина может быть оригинальной или креативной?

Тьюринг сводит это к вопросу о том, может ли машина «застать нас врасплох», и утверждает, что это, очевидно, правда, что может подтвердить любой программист.[72] Он отмечает, что при достаточном объеме памяти компьютер может вести себя астрономическим числом различных способов.[73] Для компьютера, который может представлять идеи, должно быть возможно, даже тривиально, объединить их по-новому. (Дуглас Ленат с Автоматизированный математик (например, объединили идеи для открытия новых математических истин). Каплан и Haenlein предполагают, что машины могут проявлять научное творчество, в то время как кажется вероятным, что люди будут иметь преимущество в том, что касается художественного творчества.[74]

В 2009 году ученые из Университета Аберистуита в Уэльсе и Кембриджского университета Великобритании разработали робота по имени Адам, который, по их мнению, станет первой машиной, которая самостоятельно придумала новые научные открытия.[75] Также в 2009 году исследователи из Корнелл развитый Eureqa, компьютерная программа, которая экстраполирует формулы в соответствии с введенными данными, например, определяет законы движения по движению маятника.

Может машина быть доброжелательной или враждебной?

Этот вопрос (как и многие другие в философии искусственного интеллекта) можно представить в двух формах. «Враждебность» может быть определена в терминах функция или же поведение, и в этом случае «враждебный» становится синонимом «опасного». Или это можно определить с точки зрения намерения: может ли машина «сознательно» намереваться причинить вред? Последний вопрос - "может ли машина иметь сознательные состояния?" (Такие как намерения ) в другой форме.[49]

Вопрос о том, будут ли опасны высокоинтеллектуальные и полностью автономные машины, подробно исследовался футуристами (такими как Институт сингулярности ). Очевидный элемент драмы также сделал эту тему популярной в научная фантастика, в котором рассмотрено множество различных возможных сценариев, в которых интеллектуальные машины представляют угрозу человечеству; видеть Искусственный интеллект в художественной литературе.

Одна из проблем заключается в том, что машины могут очень быстро обрести автономию и интеллект, необходимые для того, чтобы быть опасными. Вернор Виндж предположил, что всего за несколько лет компьютеры внезапно станут в тысячи или миллионы раз умнее людей. Он называет это "Сингулярность."[76] Он предполагает, что это может быть в некоторой степени или, возможно, очень опасно для человека.[77] Это обсуждается в философии, называемой Сингулярность.

В 2009 году ученые и технические эксперты посетили конференцию, на которой обсудили потенциальное влияние роботов и компьютеров, а также влияние гипотетической возможности того, что они смогут стать самодостаточными и иметь возможность принимать собственные решения. Они обсудили возможность и степень, в которой компьютеры и роботы могут получить любой уровень автономии, и в какой степени они могут использовать такие способности, чтобы создать угрозу или опасность. Они отметили, что некоторые машины приобрели различные формы полуавтономности, в том числе возможность самостоятельно находить источники энергии и возможность самостоятельно выбирать цели для атаки с помощью оружия. Они также отметили, что некоторые компьютерные вирусы могут уклоняться от уничтожения и достигли «тараканьего интеллекта». Они отметили, что самосознание, описанное в научной фантастике, вероятно, маловероятно, но есть и другие потенциальные опасности и подводные камни.[76]

Некоторые эксперты и ученые подвергают сомнению использование роботов в военных действиях, особенно когда таким роботам дается некоторая степень автономности.[78] ВМС США профинансировали отчет, в котором указывается, что по мере того, как военные роботы становятся все более сложными, следует уделять больше внимания последствиям их способности принимать автономные решения.[79][80]

Президент Ассоциация развития искусственного интеллекта заказал исследование, чтобы рассмотреть этот вопрос.[81] Они указывают на такие программы, как Устройство для определения языка который может имитировать человеческое взаимодействие.

Некоторые высказали предположение о необходимости строительства "Дружелюбный ИИ ", что означает, что успехи, которые уже происходят с ИИ, должны также включать в себя усилия, направленные на то, чтобы сделать ИИ по своей сути дружественным и гуманным.[82]

Может ли машина имитировать все человеческие характеристики?

Тьюринг сказал: «Принято ... предлагать немного утешения в форме заявления о том, что некоторая специфическая человеческая характеристика никогда не может быть воспроизведена машиной ... Я не могу предложить такого утешения, поскольку я считаю, что нет такие границы могут быть установлены ".[83]

Тьюринг отметил, что есть много аргументов в форме «машина никогда не сделает X», где X может означать множество вещей, например:

Будьте добры, находчивы, красивы, дружелюбны, проявляйте инициативу, обладайте чувством юмора, отличите хорошее от плохого, совершайте ошибки, влюбляйтесь, наслаждайтесь клубникой и сливками, заставляйте кого-то влюбиться в них, учитесь на опыте, правильно используйте слова быть предметом собственной мысли, иметь такое же разнообразие поведения, как мужчина, делать что-то действительно новое.[71]

Тьюринг утверждает, что эти возражения часто основаны на наивных предположениях об универсальности машин или являются «замаскированными формами аргументации от сознания». Написание программы, демонстрирующей одно из этих поведений, «не произведет большого впечатления».[71] Все эти аргументы касаются основной предпосылки ИИ, если только нельзя показать, что одна из этих черт важна для общего интеллекта.

Может ли у машины быть душа?

Наконец, те, кто верит в существование души, могут возразить, что «мышление - это функция человеческого бессмертный душа ». Алан Тьюринг назвал это« теологическим возражением ».

Пытаясь сконструировать такие машины, мы не должны непочтительно узурпировать Его силу созидания душ, как и в случае деторождения: скорее, в любом случае мы являемся инструментами Его воли, обеспечивающими обители для душ, которые Он создает.[84]

Взгляды на роль философии

Некоторые ученые утверждают, что игнорирование философии сообществом ИИ пагубно. в Стэнфордская энциклопедия философии, некоторые философы утверждают, что роль философии в ИИ недооценивается.[2] Физик Дэвид Дойч утверждает, что без понимания философии или ее концепций развитие ИИ будет страдать от отсутствия прогресса.[85]

Конференции

Основная серия конференций по данному вопросу: «Философия и теория искусственного интеллекта» (PT-AI), управляемый Винсент К. Мюллер.

Основная библиография по данной теме с несколькими подразделами находится на PhilPapers.

Смотрите также

- Захват AI

- Искусственный мозг

- Искусственное сознание

- Искусственный интеллект

- Искусственная нейронная сеть

- Чаттербот

- Китайская комната

- Вычислительная теория разума

- Вычислительная техника и интеллект

- Критика искусственного интеллекта Дрейфусом

- Экзистенциальный риск от продвинутого искусственного интеллекта

- Функционализм

- Многоагентная система

- Философия информатики

- Философия информации

- Философия разума

- Система физических символов

- Смоделированная реальность

- Сверхразум: пути, опасности, стратегии

- Синтетический интеллект

Примечания

- ^ Маккарти, Джон. «Философия ИИ и ИИ философии». jmc.stanford.edu. Архивировано из оригинал в 2018-10-23. Получено 2018-09-18.

- ^ а б Брингсйорд, Зельмер; Говиндараджулу, Навин Сундар (2018), "Искусственный интеллект", в Залте, Эдвард Н. (ред.), Стэнфордская энциклопедия философии (Издание осень 2018 г.), Исследовательская лаборатория метафизики Стэнфордского университета, архив из оригинал на 2019-11-09, получено 2018-09-18

- ^ Дойч, Дэвид (2012-10-03). «Философия станет ключом к открытию искусственного интеллекта | Дэвид Дойч». Хранитель. ISSN 0261-3077. Получено 2020-04-29.

- ^ Рассел и Норвиг, 2003 г., п. 947 определите философию ИИ как состоящую из первых двух вопросов и дополнительного вопроса этика искусственного интеллекта. Страх 2007, п. 55 пишет: «В современной литературе философия играет две главные роли: определять, будут ли такие машины сознательными, и, во-вторых, предсказывать, возможны ли такие машины». Последний вопрос касается первых двух.

- ^ а б Это пересказ существенного момента Тест Тьюринга. Тьюринг 1950, Хогеланд 1985, стр. 6–9, Crevier 1993, п. 24, Рассел и Норвиг, 2003 г., стр. 2–3 и 948

- ^ а б Маккарти и др. 1955 г.. Это утверждение было напечатано в программе для Дартмутская конференция 1956 года, который широко считается «рождением AI». Crevier 1993, п. 28

- ^ а б Ньюэлл и Саймон 1976 и Рассел и Норвиг, 2003 г., п. 18

- ^ а б c d Эта версия от Сирл (1999), а также цитируется в Деннет 1991, п. 435. Первоначальная формулировка Сирла заключалась в следующем: «Соответственно запрограммированный компьютер на самом деле является разумом в том смысле, что можно буквально сказать, что компьютеры, получившие правильные программы, понимают и имеют другие когнитивные состояния». (Сирл 1980, п. 1). Сильный ИИ определяется аналогично Рассел и Норвиг (2003 г., п. 947): «Утверждение, что машины могут действовать разумно (или, что лучше, действовать так, как если бы они были разумными), философы называют гипотезой« слабого ИИ », а утверждение, что машины, которые так поступают, на самом деле думают (в отличие от моделирования мышление) называется гипотезой «сильного ИИ» ".

- ^ а б Гоббс 1651, гл. 5

- ^ Видеть Рассел и Норвиг, 2003 г., п. 3, где они проводят различие между игра актеров рационально и существование рациональным, и определяем ИИ как исследование первого.

- ^ Тьюринг, Алан М. (1950). «Вычислительная техника и интеллект». Разум. 49: 433–460 - через зубчатые отпечатки.

- ^ Хедер, Михай; Пакси, Даниэль (2012). «Автономные роботы и неявное знание». Оценка. 9 (2): 8–14 - через academia.edu.

- ^ Сайгин 2000.

- ^ Тьюринг 1950 и увидеть Рассел и Норвиг, 2003 г., п. 948, где они называют его статью «известной» и пишут: «Тьюринг исследовал широкий спектр возможных возражений против возможности создания интеллектуальных машин, включая практически все возражения, выдвинутые за полвека с момента появления его статьи».

- ^ Тьюринг 1950 в разделе «Аргумент от сознания»

- ^ Рассел и Норвиг, 2003 г., п. 3

- ^ Рассел и Норвиг, 2003 г., стр. 4–5, 32, 35, 36 и 56

- ^ Рассел и Норвиг предпочли бы слово "рациональный "умным".

- ^ «Искусственная глупость». Экономист. 324 (7770): 14. 1 августа 1992 г.

- ^ Сайгин, А.П .; Чичекли, И. (2002). «Прагматика в разговоре человек-компьютер». Журнал прагматики. 34 (3): 227–258. CiteSeerX 10.1.1.12.7834. Дои:10.1016 / S0378-2166 (02) 80001-7.

- ^ Рассел и Норвиг (2003 г., стр. 48–52). Считайте термостат простой формой интеллектуальный агент, известный как рефлекторный агент. Более подробно о роли термостата в философии см. Чалмерс (1996, pp. 293–301) «4. Вездесущ ли опыт?» подразделы Каково быть термостатом?, Куда идет панпсихизм?, и Ограничение принципа двойственности.

- ^ Дрейфус 1972, п. 106

- ^ Питтс и Маккалоу, 1943 г.

- ^ Моравец 1988

- ^ Курцвейл 2005, п. 262. См. Также Рассел и Норвиг, п. 957 и Crevier 1993, стр. 271 и 279. Наиболее крайняя форма этого аргумента (сценарий замены мозга) была выдвинута Кларк Глимор в середине 1970-х и был затронут Зенон Пилишин и Джон Сирл в 1980 году

- ^ Евгений Ижикевич (27.10.2005). "Евгений Ижикевич, Масштабное моделирование человеческого мозга". Vesicle.nsi.edu. Архивировано из оригинал на 2009-05-01. Получено 2010-07-29.

- ^ Хьюберт Дрейфус пишет: «В целом, принимая фундаментальные предположения о том, что нервная система является частью физического мира и что все физические процессы могут быть описаны в математическом формализме, которым, в свою очередь, можно управлять с помощью цифрового компьютера, можно приходят к убедительному утверждению, что поведение, являющееся результатом человеческой «обработки информации», независимо от того, формализуется она прямо или нет, всегда может быть косвенно воспроизведено на цифровой машине ». (Дрейфус 1972, стр. 194–5). Джон Сирл пишет: «Может ли машина, созданная человеком, думать? Если предположить, что можно искусственно создать машину с нервной системой, ... ответ на вопрос кажется очевидным, да ... Может ли цифровой компьютер думать? Если с помощью цифрового компьютера 'вы имеете в виду все, что имеет уровень описания, на котором это может быть правильно описано как реализация компьютерной программы, то опять же ответ, конечно, да, поскольку мы являемся экземплярами любого количества компьютерных программ, и мы можем думать ». (Сирл 1980, п. 11)

- ^ Сирл 1980, п. 7

- ^ Сирл пишет: «Мне нравится прямолинейность утверждения». Сирл 1980, п. 4

- ^ Дрейфус 1979, п. 156

- ^ Гёдель, Курт, 1951, Некоторые основные теоремы об основах математики и их применение в Соломон Феферман, изд., 1995. Собрание сочинений / Курт Гёдель, Vol. III. Oxford University Press: 304-23. - В этой лекции Гёдель использует теорему о неполноте, чтобы прийти к следующей дизъюнкции: (а) человеческий разум не является последовательной конечной машиной, или (б) существует Диофантовы уравнения для которого он не может решить, существуют ли решения. Гёдель находит (б) неправдоподобным и, таким образом, кажется, полагал, что человеческий разум не эквивалентен конечной машине, то есть его мощность превышала мощность любой конечной машины. Он признал, что это всего лишь предположение, поскольку никто не может опровергнуть (б). Тем не менее, он считал дизъюнктивный вывод «несомненным фактом».

- ^ Лукас 1961, Рассел и Норвиг, 2003 г., стр. 949–950, Хофштадтер 1979, стр. 471–473, 476–477

- ^ Грэм Оппи (20 января 2015 г.). «Теоремы Гёделя о неполноте». Стэнфордская энциклопедия философии. Получено 27 апреля 2016.

Однако эти геделевские антимеханистские аргументы проблематичны, и существует широкий консенсус в отношении того, что они не работают.

- ^ Стюарт Дж. Рассел; Питер Норвиг (2010). «26.1.2: Философские основы / Слабый ИИ: могут ли машины действовать разумно? / Математическое возражение». Искусственный интеллект: современный подход (3-е изд.). Река Аппер Сэдл, штат Нью-Джерси: Prentice Hall. ISBN 978-0-13-604259-4.

... даже если мы допустим, что у компьютеров есть ограничения на то, что они могут доказать, нет никаких доказательств того, что люди застрахованы от этих ограничений.

- ^ Марк Коливан. Введение в философию математики. Издательство Кембриджского университета, 2012. Из 2.2.2, «Философское значение результатов неполноты Гёделя»: «Общепринятая мудрость (с которой я согласен) состоит в том, что аргументы Лукаса-Пенроуза терпят неудачу».

- ^ ЛаФорте, Г., Хейс, П. Дж., Форд, К. М. 1998. Почему теорема Гёделя не может опровергнуть вычислительный подход. Искусственный интеллект, 104:265-286, 1998.

- ^ Рассел и Норвиг, 2003 г., п. 950 Они указывают, что реальные машины с конечной памятью можно моделировать, используя логика высказываний, что формально разрешимый, и аргумент Гёделя к ним совершенно не применим.

- ^ Хофштадтер 1979

- ^ В соответствии с Хофштадтер 1979, pp. 476–477, это утверждение впервые было предложено К. Х. Уайтли

- ^ Хофштадтер 1979, стр. 476–477, Рассел и Норвиг, 2003 г., п. 950, Тьюринг 1950 в «Аргументе из математики», где он пишет, «хотя установлено, что существуют ограничения для возможностей любой конкретной машины, было только заявлено, без каких-либо доказательств, что такие ограничения не применимы к человеческому интеллекту».

- ^ Пенроуз 1989

- ^ Литт, Абниндер; Элиасмит, Крис; Kroon, Frederick W .; Вайнштейн, Стивен; Тагард, Пол (6 мая 2006 г.). «Является ли мозг квантовым компьютером?». Наука о мышлении. 30 (3): 593–603. Дои:10.1207 / с15516709cog0000_59. PMID 21702826.

- ^ Дрейфус 1972, Дрейфус 1979, Дрейфус и Дрейфус 1986. Смотрите также Рассел и Норвиг, 2003 г., стр. 950–952, Crevier 1993, стр. 120–132 и Хирн 2007, стр. 50–51

- ^ Рассел и Норвиг, 2003 г., стр. 950–51

- ^ Тьюринг 1950 в разделе «(8) Аргумент от неформального поведения»

- ^ а б Рассел и Норвиг, 2003 г., п. 52

- ^ Видеть Брукс 1990 и Моравец 1988

- ^ Crevier 1993, п. 125

- ^ а б Тьюринг 1950 в разделе «(4) Аргумент от сознания». Смотрите также Рассел и Норвиг, стр. 952–3, где они отождествляют аргумент Сирла с «Аргументом сознания» Тьюринга.

- ^ Рассел и Норвиг, 2003 г., п. 947

- ^ «[П] люди всегда говорят мне, что было очень трудно дать определение сознанию, но я думаю, если вы просто ищете такое определение здравого смысла, которое вы получаете в начале исследования, а не твердое научное определение, которое приходит в конце, нетрудно дать здравое определение сознания ". Зона философа: вопрос о сознании. Также см Деннет 1991

- ^ Блэкмор 2005, п. 2

- ^ Рассел и Норвиг, 2003 г., стр. 954–956

- ^ Например, Джон Сирл пишет: «Может ли машина мыслить? Ответ очевиден - да. Мы именно такие машины». (Сирл 1980, п. 11)

- ^ Сирл 1980. Смотрите также Коул 2004, Рассел и Норвиг, 2003 г., стр. 958–960, Crevier 1993, стр. 269–272 и Хирн 2007, стр. 43–50

- ^ Сирл 1980, п. 13

- ^ Searle 1984

- ^ Коул 2004, 2.1, Лейбниц 1714, 17

- ^ Коул 2004, 2.3

- ^ Сирл 1980 в разделе «1. Ответ системы (Беркли)», Crevier 1993, п. 269, Рассел и Норвиг, 2003 г., п. 959, Коул 2004, 4.1. Среди тех, кто придерживается «системной» позиции (по мнению Коула), - Нед Блок, Джек Коупленд, Дэниел Деннетт, Джерри Фодор, Джон Хогеланд, Рэй Курцвейл и Жорж Рей. Среди тех, кто защищал ответ «виртуального разума», Марвин Мински, Алан Перлис, Дэвид Чалмерс, Нед Блок и Дж. Коул (опять же, согласно Коул 2004 )

- ^ Коул 2004, 4.2 приписывает эту позицию Нед Блок, Дэниел Деннет, Тим Модлин, Дэвид Чалмерс, Стивен Пинкер, Патрисия Черчленд и другие.

- ^ Сирл 1980 в разделе «2. Ответ робота (Йельский университет)». Коул 2004, 4.3 приписывает эту позицию Маргарет Боден, Тим Крейн, Дэниел Деннет, Джерри Фодор, Стеван Харнад, Ханс Моравец и Жорж Рей

- ^ Цитируется в Crevier 1993, п. 272

- ^ Сирл 1980 в разделе «3. Ответ симулятора мозга (Беркли и Массачусетский технологический институт)» Коул 2004 приписывает эту позицию Павел и Патрисия Черчленд и Рэй Курцвейл

- ^ Сирл 1980 в разделе «5. Ответ других умов», Коул 2004, 4.4. Тьюринг 1950 дает этот ответ в рубрике «(4) Аргумент сознания». Коул приписывает эту позицию Дэниелу Деннету и Гансу Моравеку.

- ^ Дрейфус 1979, п. 156, г. Хогеланд 1985, стр. 15–44

- ^ Хорст 2005

- ^ а б Харнад 2001

- ^ а б Цитируется в Crevier 1993, п. 266

- ^ Crevier 1993, п. 266

- ^ а б c Тьюринг 1950 в разделе «(5) Аргументы от различных недугов»

- ^ Тьюринг 1950 под "(6) Возражение леди Лавлейс"

- ^ Тьюринг 1950 в разделе «(5) Аргумент от различных недугов»

- ^ «Каплан Андреас; Майкл Хенлайн». Бизнес-горизонты. 62 (1): 15–25. Январь 2019. Дои:10.1016 / j.bushor.2018.08.004.

- ^ Кац, Лесли (2009-04-02). «Робо-ученый сам делает открытие генов | Crave - CNET». News.cnet.com. Получено 2010-07-29.

- ^ а б Ученые опасаются, что машины могут перехитрить человека ДЖОН МАРКОФФ, NY Times, 26 июля 2009 г.

- ^ Грядущая технологическая сингулярность: как выжить в постчеловеческую эру, Вернор Виндж, Департамент математических наук, Государственный университет Сан-Диего, (c) 1993 Вернор Виндж.

- ^ Призыв к дискуссии о роботах-убийцах, Джейсон Палмер, репортер по науке и технологиям, BBC News, 3 августа 2009 г.

- ^ Наука Новый отчет, финансируемый ВМФ, предупреждает о приближении боевых роботов к «Терминатору» В архиве 2009-07-28 на Wayback Machine, Джейсон Мик (блог), dailytech.com, 17 февраля 2009 г.

- ^ Отчет ВМФ предупреждает о восстании роботов и предлагает сильный моральный компас, Джозеф Л. Флэтли engadget.com, 18 февраля 2009 г.

- ^ Президентская комиссия AAAI по исследованию долгосрочного будущего ИИ на 2008-2009 гг., Association for the Advancement of Artificial Intelligence, дата обращения 26.07.09.

- ^ Статья на Asimovlaws.com, Июль 2004 г., по состоянию на 27 июля 2009 г. В архиве 30 июня 2009 г. Wayback Machine

- ^ «Могут ли цифровые компьютеры думать?». Беседа в Третьей программе BBC, 15 мая 1951 года. http://www.turingarchive.org/viewer/?id=459&title=8

- ^ Тьюринг 1950 в разделе «(1) Теологическое возражение», хотя он также пишет: «Я не очень впечатлен теологическими аргументами, какие бы они ни использовались для подтверждения»

- ^ Дойч, Дэвид (2012-10-03). «Философия станет ключом к открытию искусственного интеллекта | Дэвид Дойч». хранитель. Получено 2018-09-18.

Рекомендации

- Блэкмор, Сьюзен (2005), Сознание: очень краткое введение, Oxford University Press

- Бостром, Ник (2014), Сверхразум: пути, опасности, стратегии, Oxford University Press, ISBN 978-0-19-967811-2

- Брукс, Родни (1990), «Слоны не играют в шахматы» (PDF), Робототехника и автономные системы, 6 (1–2): 3–15, CiteSeerX 10.1.1.588.7539, Дои:10.1016 / S0921-8890 (05) 80025-9, получено 2007-08-30

- Чалмерс, Дэвид Дж. (1996), Сознательный разум: в поисках фундаментальной теории, Oxford University Press, Нью-Йорк, ISBN 978-0-19-511789-9

- Коул, Дэвид (осень 2004 г.), «Аргумент о китайской комнате», в Zalta, Эдвард Н. (ред.), Стэнфордская энциклопедия философии.

- Кревье, Даниэль (1993), AI: бурные поиски искусственного интеллекта, Нью-Йорк, Нью-Йорк: BasicBooks, ISBN 0-465-02997-3

- Деннет, Дэниел (1991), Сознание объяснено, Пингвин Пресс, ISBN 978-0-7139-9037-9

- Дрейфус, Хуберт (1972), Чего не умеют компьютеры, Нью-Йорк: MIT Press, ISBN 978-0-06-011082-6

- Дрейфус, Хуберт (1979), Какие компьютеры Все еще Не могу сделать, Нью-Йорк: MIT Press..

- Дрейфус, Хуберт; Дрейфус, Стюарт (1986), Разум важнее машины: сила человеческой интуиции и опыта в эпоху компьютеров, Оксфорд, Великобритания: Блэквелл

- Fearn, Николас (2007), Последние ответы на самые старые вопросы: философское приключение с величайшими мыслителями мира, Нью-Йорк: Grove Press

- Гладуэлл, Малькольм (2005), Blink: сила мышления без мышления, Бостон: Маленький, Браун, ISBN 978-0-316-17232-5.

- Харнад, Стеван (2001), «Что не так и правильно в аргументе Сирла о китайской комнате?», В Bishop, M .; Престон, Дж. (Ред.), Очерки аргументации Сирла о китайской комнате, Oxford University Press

- Haugeland, Джон (1985), Искусственный интеллект: сама идея, Кембридж, Массачусетс: MIT Press.

- Гоббс (1651), Левиафан.

- Хофштадтер, Дуглас (1979), Гедель, Эшер, Бах: вечная золотая коса.

- Хорст, Стивен (2009), «Вычислительная теория разума», в Zalta, Эдвард Н. (ред.), Стэнфордская энциклопедия философии, Исследовательская лаборатория метафизики Стэнфордского университета.

- Каплан, Андреас; Хайнлайн, Майкл (2018), «Siri, Siri в моей руке, кто самый справедливый в стране? Об интерпретации, иллюстрациях и значениях искусственного интеллекта», Бизнес-горизонты, 62: 15–25, Дои:10.1016 / j.bushor.2018.08.004

- Курцвейл, Рэй (2005), Сингулярность близка, Нью-Йорк: Viking Press, ISBN 978-0-670-03384-3.

- Лукас, Джон (1961), «Умы, машины и Гёдель», в Anderson, A.R. (ред.), Умы и машины.

- Маккарти, Джон; Минский, Марвин; Рочестер, Натан; Шеннон, Клод (1955), Предложение для Дартмутского летнего исследовательского проекта по искусственному интеллекту, заархивировано из оригинал на 2008-09-30.

- Макдермотт, Дрю (14 мая 1997 г.), "Насколько интеллектуален Deep Blue", Нью-Йорк Таймс, заархивировано из оригинал 4 октября 2007 г., получено 10 октября, 2007

- Моравец, Ганс (1988), Дети разума, Издательство Гарвардского университета

- Ньюэлл, Аллен; Саймон, Х.А. (1963), «GPS: программа, имитирующая человеческую мысль», в Feigenbaum, E.A .; Фельдман, Дж. (Ред.), Компьютеры и мысль, Нью-Йорк: Макгроу-Хилл

- Ньюэлл, Аллен; Саймон, Х.А. (1976), «Информатика как эмпирическое исследование: символы и поиск», Коммуникации ACM, 19, заархивировано из оригинал на 2008-10-07

- Рассел, Стюарт Дж.; Норвиг, Питер (2003), Искусственный интеллект: современный подход (2-е изд.), Верхняя Сэдл-Ривер, Нью-Джерси: Prentice Hall, ISBN 0-13-790395-2

- Пенроуз, Роджер (1989), Новый разум императора: о компьютерах, разуме и законах физики, Издательство Оксфордского университета, ISBN 978-0-14-014534-2

- Сирл, Джон (1980), «Умы, мозги и программы» (PDF), Поведенческие науки и науки о мозге, 3 (3): 417–457, Дои:10.1017 / S0140525X00005756, заархивировано из оригинал (PDF) на 2015-09-23

- Сирл, Джон (1992), Новое открытие разума, Кембридж, Массачусетс: M.I.T. Нажмите

- Сирл, Джон (1999), Разум, язык и общество, Нью-Йорк, Нью-Йорк: Основные книги, ISBN 978-0-465-04521-1, OCLC 231867665

- Тьюринг, Алан (Октябрь 1950 г.), «Вычислительная техника и интеллект», Разум, LIX (236): 433–460, Дои:10.1093 / разум / LIX.236.433, ISSN 0026-4423

- Да, Ричард (1993), «Машины Тьюринга и обработка семантических символов: почему настоящие компьютеры не возражают против китайских императоров» (PDF), Лицей, 5 (1): 37–59

- Номера страниц выше и содержание диаграмм относятся к лицее. PDF печать статьи.