Нелинейная регрессия - Nonlinear regression - Wikipedia

| Часть серии по |

| Регрессивный анализ |

|---|

|

| Модели |

| Оценка |

| Фон |

|

В статистике нелинейная регрессия это форма регрессивный анализ в котором данные наблюдений моделируются функцией, которая представляет собой нелинейную комбинацию параметров модели и зависит от одной или нескольких независимых переменных. Данные аппроксимированы методом последовательных приближений.

Общий

В нелинейной регрессии a статистическая модель формы,

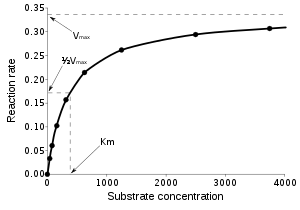

связывает вектор независимые переменные, , и связанные с ним наблюдаемые зависимые переменные, . Функция нелинейна по компонентам вектора параметров , но в остальном произвольно. Например, Михаэлис-Ментен Модель кинетики ферментов имеет два параметра и одну независимую переменную, связанные соотношением к:[а]

Эта функция является нелинейной, потому что ее нельзя выразить как линейная комбинация из двух с.

Систематическая ошибка может присутствовать в независимых переменных, но его обработка выходит за рамки регрессионного анализа. Если независимые переменные не свободны от ошибок, это модель ошибок в переменных, также за пределами этой области.

Другие примеры нелинейных функций включают: экспоненциальные функции, логарифмические функции, тригонометрические функции, степенные функции, Функция Гаусса, и Кривые Лоренца. Некоторые функции, такие как экспоненциальные или логарифмические функции, можно преобразовать так, чтобы они стали линейными. При таком преобразовании можно выполнить стандартную линейную регрессию, но ее следует применять с осторожностью. Видеть Линеаризация§Преобразование ниже, для более подробной информации.

В общем, не существует выражения в закрытой форме для наиболее подходящих параметров, как в линейная регрессия. Обычно числовой оптимизация применяются алгоритмы для определения наиболее подходящих параметров. Опять же, в отличие от линейной регрессии, может быть много локальные минимумы функции, которую нужно оптимизировать, и даже глобальный минимум может дать пристрастный оценивать. На практике, оценочные значения параметров используются вместе с алгоритмом оптимизации, чтобы попытаться найти глобальный минимум суммы квадратов.

Подробнее о нелинейном моделировании данных см. наименьших квадратов и нелинейный метод наименьших квадратов.

Статистика регрессии

Предположение, лежащее в основе этой процедуры, состоит в том, что модель может быть аппроксимирована линейной функцией, а именно первым порядком Серия Тейлор:

куда . Из этого следует, что оценки наименьших квадратов имеют вид

Статистика нелинейной регрессии вычисляется и используется как в статистике линейной регрессии, но с использованием J на месте Икс в формулах. Линейное приближение вводит предвзятость в статистику. Поэтому при интерпретации статистики, полученной из нелинейной модели, требуется больше осторожности, чем обычно.

Обычные и взвешенные методы наименьших квадратов

Кривая наилучшего соответствия часто считается такой, которая минимизирует сумму квадратов остатки. Это обыкновенный метод наименьших квадратов (OLS) подход. Однако в случаях, когда зависимая переменная не имеет постоянной дисперсии, сумма взвешенных квадратов остатков может быть минимизирована; видеть взвешенный метод наименьших квадратов. Каждый вес в идеале должен быть равен обратной величине дисперсии наблюдения, но веса могут быть пересчитаны на каждой итерации в итеративно взвешенном алгоритме наименьших квадратов.

Линеаризация

Трансформация

Некоторые задачи нелинейной регрессии можно переместить в линейную область с помощью подходящего преобразования формулировки модели.

Например, рассмотрим задачу нелинейной регрессии

с параметрами а и б и с мультипликативным членом ошибки U. Если мы возьмем логарифм обеих сторон, это станет

куда ты = ln (U), предлагая оценить неизвестные параметры линейной регрессией ln (у) на Икс, вычисление, не требующее итеративной оптимизации. Однако использование нелинейного преобразования требует осторожности. Влияние значений данных изменится, как и структура ошибок модели и интерпретация любых выводимых результатов. Это могут быть нежелательные эффекты. С другой стороны, в зависимости от того, что является наибольшим источником ошибки, нелинейное преобразование может распределять ошибки по гауссовскому принципу, поэтому выбор выполнения нелинейного преобразования должен основываться на соображениях моделирования.

За Кинетика Михаэлиса – Ментен линейный Заговор Лайнуивера – Берка

из 1 /v против 1 / [S] широко использовался. Однако, поскольку он очень чувствителен к ошибкам данных и сильно склонен к подгонке данных в конкретный диапазон независимой переменной, [S], его использование настоятельно не рекомендуется.

Для распределений ошибок, принадлежащих экспоненциальная семья, функция ссылки может использоваться для преобразования параметров в Обобщенная линейная модель рамки.

Сегментация

В независимый или же объясняющая переменная (скажем, X) можно разделить на классы или сегменты и линейная регрессия может выполняться по сегментам. Сегментированная регрессия с анализ доверия может привести к тому, что зависимый или же отклик Переменная (скажем Y) ведет себя по-разному в разных сегментах.[1]

На рисунке видно, что засоление почвы (X) изначально не влияет на урожай (Y) горчицы, пока критический или же порог ценить (точка останова), после чего отрицательно сказывается на доходности.[2]

Смотрите также

Рекомендации

- ^ Р. Дж. Остербан, 1994, Частотный и регрессионный анализ. В: Х.П. Ритзема (ред.), Принципы и применение дренажа, Publ. 16, стр. 175-224, Международный институт мелиорации и улучшения земель (ILRI), Вагенинген, Нидерланды. ISBN 90-70754-33-9 . Скачать как PDF: [1]

- ^ Р. Дж. Остербан, 2002. Исследование дренажа на сельскохозяйственных полях: анализ данных. Часть проекта «Жидкое золото» Международного института мелиорации и улучшения земель (ILRI), Вагенинген, Нидерланды. Скачать как PDF: [2]. Фигура была сделана с SegReg программу, которую можно бесплатно скачать с [3]

Примечания

- ^ Эта модель также может быть выражена в общепринятых биологических обозначениях:

дальнейшее чтение

- Bethea, R.M .; Duran, B.S .; Буллион, Т. Л. (1985). Статистические методы для инженеров и ученых. Нью-Йорк: Марсель Деккер. ISBN 0-8247-7227-X.

- Meade, N .; Ислам, Т. (1995). «Интервалы прогнозирования для прогнозов кривой роста». Журнал прогнозирования. 14 (5): 413–430. Дои:10.1002 / для 3980140502.

- Schittkowski, K. (2002). Подгонка данных в динамических системах. Бостон: Клувер. ISBN 1402010796.

- Себер, Г. А. Ф .; Уайлд, К. Дж. (1989). Нелинейная регрессия. Нью-Йорк: Джон Уайли и сыновья. ISBN 0471617601.

![{ frac {1} {v}} = { frac {1} {V _ { max}}} + { frac {K_ {m}} {V _ {{ max}} [S]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fb44905c5bb097edbf610f26176e996180c36ac7)

![v = { frac {V _ { max} [{ mbox {S}}]} {K_ {m} + [{ mbox {S}}]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ddb07a5f0c5464d685c5ab5072a8bee836260b6d)